Используйте dbt для создания аналитических и готовых к ML пайплайнов с помощью SQL и Python в Snowflake

Введение

Основной фокус этого воркшопа — показать, как мы можем использовать SQL и Python вместе в рамках одного рабочего процесса, чтобы запускать как аналитические, так и машинно‑обучающие модели на dbt.

Весь код сегодняшнего воркшопа можно найти на GitHub.

Что вы будете использовать во время лабораторной работы

Чему вы научитесь

- Как строить масштабируемые конвейеры преобразования данных с использованием dbt и Snowflake с помощью SQL и Python

- Как использовать копирование данных в Snowflake из публичного S3-бакета

Что вам нужно знать

- Базовые и средние знания SQL и Python.

- Базовое понимание основ dbt. Мы рекомендуем курс dbt Fundamentals, если вам интересно.

- Общий процесс машинного обучения (кодирование, обучение, тестирование)

- Простые алгоритмы ML — мы будем использовать логистическую регрессию, чтобы сосредоточиться на рабочем процессе, а не на алгоритмах!

Что вы создадите

- Набор аналитических и предсказательных конвейеров данных, используя данные Формулы 1, с использованием dbt и Snowflake, применяя лучшие практики, такие как тесты качества данных и продвижение кода между средами

- Мы создадим инсайты для:

- Поиск среднего времени круга и скользящего среднего за годы (в целом оно увеличивается или уменьшается)?

- Какой конструктор имеет самые быстрые пит-стопы в 2021 году?

- Прогнозирование позиции каждого водителя, используя данные за десятилетие (2010 - 2020)

В качестве входных данных мы будем использовать наборы данных Формулы 1, размещенные в публичном S3-бакете dbt Labs. Мы создадим Snowflake Stage для наших CSV-файлов, а затем используем функцию Snowflake COPY INTO, чтобы скопировать данные из наших CSV-файлов в таблицы. Данные Формулы 1 доступны на Kaggle. Данные изначально собраны из Ergast Developer API.

В целом, мы настроим среды, построим масштабируемые конвейеры в dbt, установим тесты данных и продвинем код в производство.

Настройка Snowflake

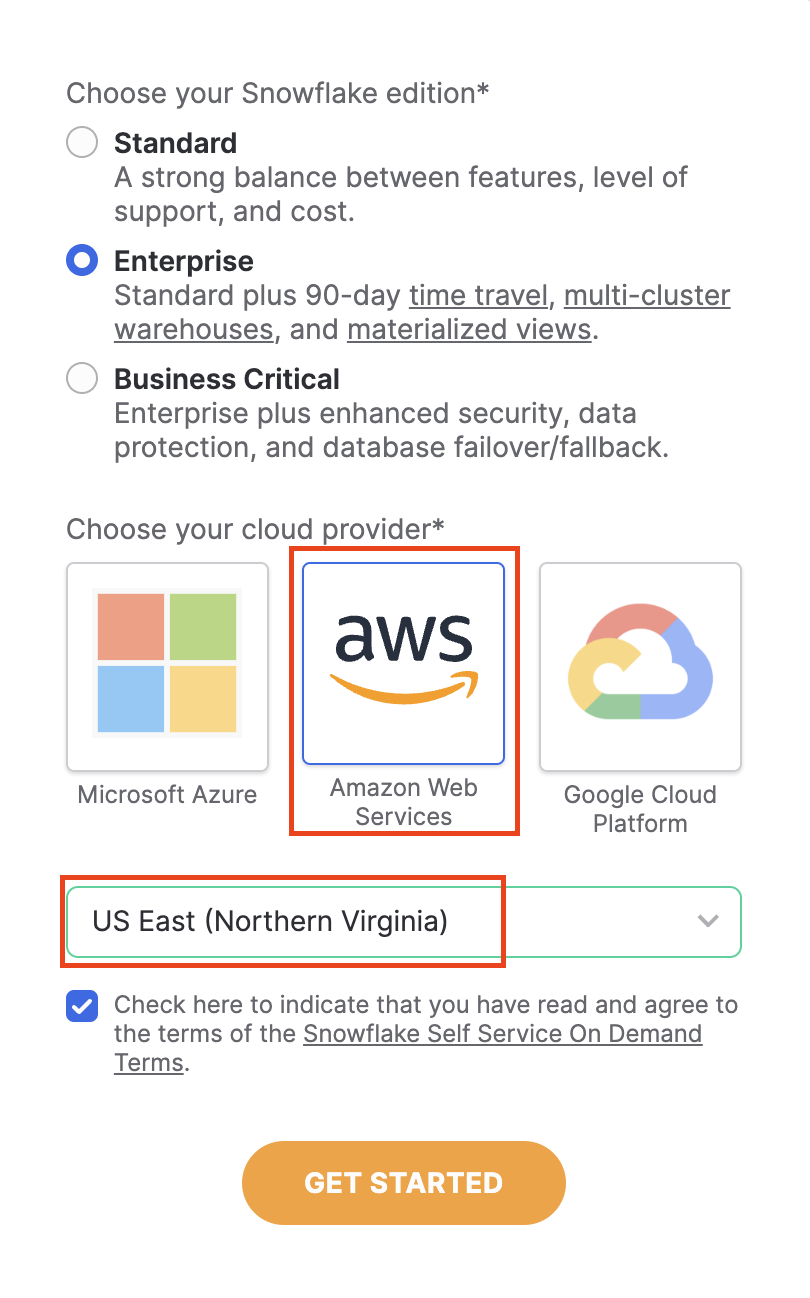

- Войдите в свой пробный аккаунт Snowflake. Вы можете зарегистрироваться для пробного аккаунта Snowflake, используя эту форму, если у вас его нет.

- Убедитесь, что ваш аккаунт настроен с использованием AWS в US East (N. Virginia). Мы будем копировать данные из публичного AWS S3-бакета, размещенного dbt Labs в регионе us-east-1. Убедившись, что наша настройка среды Snowflake соответствует региону нашего бакета, мы избегаем любых задержек при копировании и извлечении данных между регионами.

-

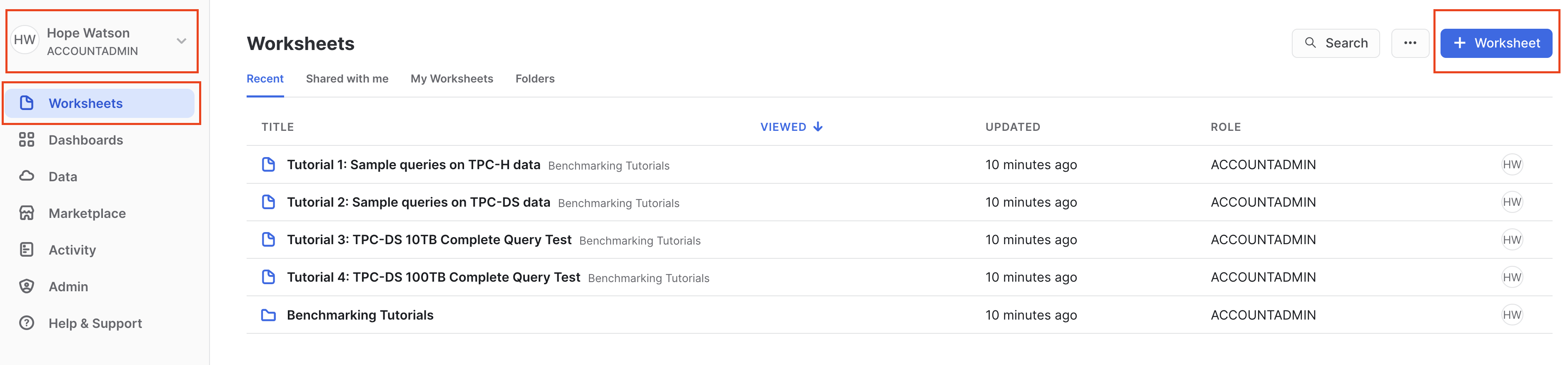

После создания вашего аккаунта и его подтверждения из письма для регистрации, Snowflake перенаправит вас обратно в интерфейс, называемый Snowsight.

-

Когда Snowsight впервые открывается, ваше окно должно выглядеть следующим образом, с вами, вошедшим в систему как ACCOUNTADMIN с открытыми демонстрационными листами:

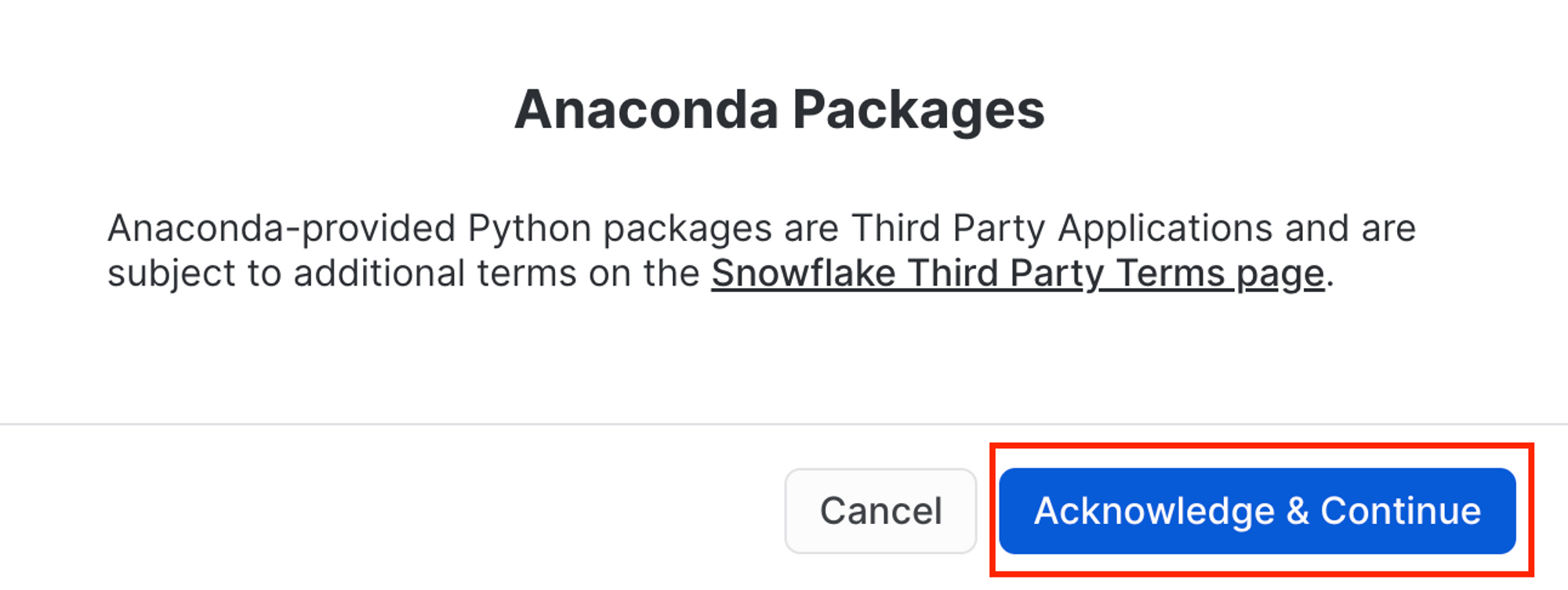

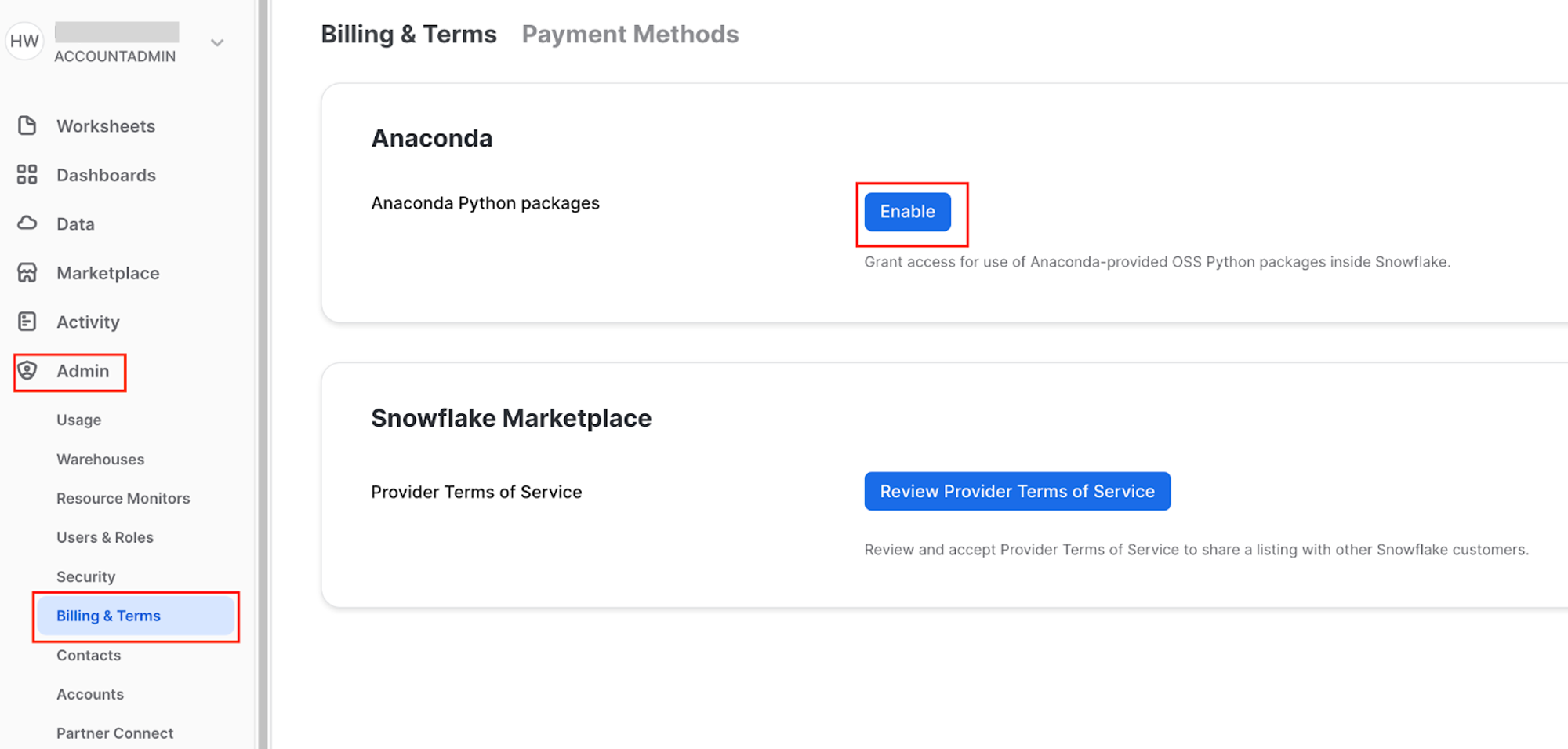

- Перейдите в Admin > Billing & Terms. Нажмите Enable > Acknowledge & Continue, чтобы включить пакеты Anaconda Python для работы в Snowflake.

- Наконец, создайте новый лист, выбрав + Worksheet в правом верхнем углу.

Подключение к источнику данных

Нам нужно получить наш источник данных, скопировав наши данные Формулы 1 в таблицы Snowflake из публичного S3-бакета, который размещает dbt Labs.

-

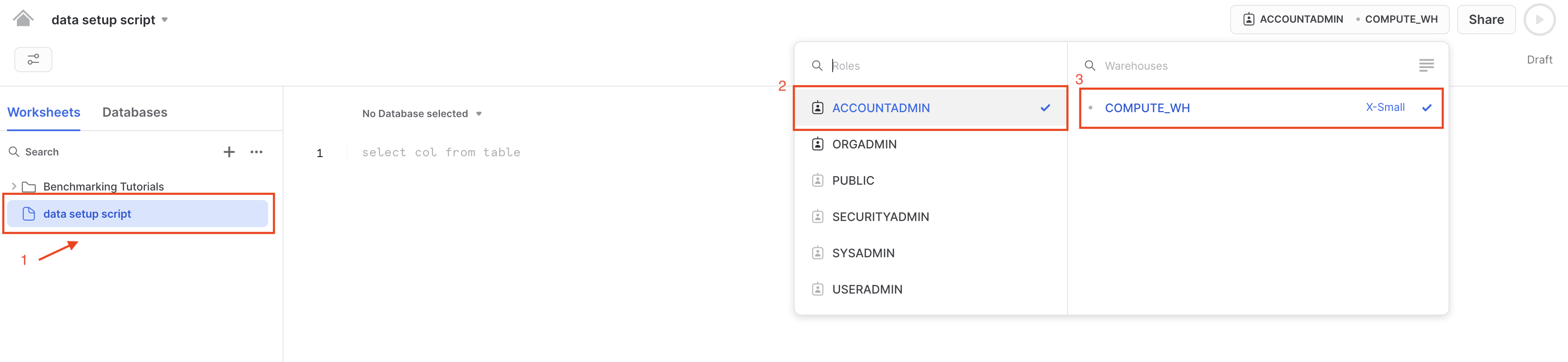

Когда создается новый аккаунт Snowflake, в вашем аккаунте должен быть предварительно настроенный склад с именем

COMPUTE_WH. -

Если по какой-либо причине в вашем аккаунте нет этого склада, мы можем создать склад, используя следующий скрипт:

create or replace warehouse COMPUTE_WH with warehouse_size=XSMALL -

Переименуйте лист в

data setup script, так как мы будем размещать код в этом листе для загрузки данных Формулы 1. Убедитесь, что вы все еще вошли в систему как ACCOUNTADMIN и выберите склад COMPUTE_WH. -

Скопируйте следующий код в основное тело листа Snowflake. Вы также можете найти этот скрипт настройки в папке

setupв Git-репозитории. Скрипт длинный, так как он загружает все данные, которые нам понадобятся сегодня!-- create and define our formula1 database

create or replace database formula1;

use database formula1;

create or replace schema raw;

use schema raw;

-- define our file format for reading in the CSVs

create or replace file format CSVformat

type = CSV

field_delimiter =','

field_optionally_enclosed_by = '"',

skip_header=1;

--

create or replace stage formula1_stage

file_format = CSVformat

url = 's3://formula1-dbt-cloud-python-demo/formula1-kaggle-data/';

-- load in the 8 tables we need for our demo

-- we are first creating the table then copying our data in from s3

-- think of this as an empty container or shell that we are then filling

create or replace table formula1.raw.circuits (

CIRCUITID NUMBER(38,0),

CIRCUITREF VARCHAR(16777216),

NAME VARCHAR(16777216),

LOCATION VARCHAR(16777216),

COUNTRY VARCHAR(16777216),

LAT FLOAT,

LNG FLOAT,

ALT NUMBER(38,0),

URL VARCHAR(16777216)

);

-- copy our data from public s3 bucket into our tables

copy into circuits

from @formula1_stage/circuits.csv

on_error='continue';

create or replace table formula1.raw.constructors (

CONSTRUCTORID NUMBER(38,0),

CONSTRUCTORREF VARCHAR(16777216),

NAME VARCHAR(16777216),

NATIONALITY VARCHAR(16777216),

URL VARCHAR(16777216)

);

copy into constructors

from @formula1_stage/constructors.csv

on_error='continue';

create or replace table formula1.raw.drivers (

DRIVERID NUMBER(38,0),

DRIVERREF VARCHAR(16777216),

NUMBER VARCHAR(16777216),

CODE VARCHAR(16777216),

FORENAME VARCHAR(16777216),

SURNAME VARCHAR(16777216),

DOB DATE,

NATIONALITY VARCHAR(16777216),

URL VARCHAR(16777216)

);

copy into drivers

from @formula1_stage/drivers.csv

on_error='continue';

create or replace table formula1.raw.lap_times (

RACEID NUMBER(38,0),

DRIVERID NUMBER(38,0),

LAP NUMBER(38,0),

POSITION FLOAT,

TIME VARCHAR(16777216),

MILLISECONDS NUMBER(38,0)

);

copy into lap_times

from @formula1_stage/lap_times.csv

on_error='continue';

create or replace table formula1.raw.pit_stops (

RACEID NUMBER(38,0),

DRIVERID NUMBER(38,0),

STOP NUMBER(38,0),

LAP NUMBER(38,0),

TIME VARCHAR(16777216),

DURATION VARCHAR(16777216),

MILLISECONDS NUMBER(38,0)

);

copy into pit_stops

from @formula1_stage/pit_stops.csv

on_error='continue';

create or replace table formula1.raw.races (

RACEID NUMBER(38,0),

YEAR NUMBER(38,0),

ROUND NUMBER(38,0),

CIRCUITID NUMBER(38,0),

NAME VARCHAR(16777216),

DATE DATE,

TIME VARCHAR(16777216),

URL VARCHAR(16777216),

FP1_DATE VARCHAR(16777216),

FP1_TIME VARCHAR(16777216),

FP2_DATE VARCHAR(16777216),

FP2_TIME VARCHAR(16777216),

FP3_DATE VARCHAR(16777216),

FP3_TIME VARCHAR(16777216),

QUALI_DATE VARCHAR(16777216),

QUALI_TIME VARCHAR(16777216),

SPRINT_DATE VARCHAR(16777216),

SPRINT_TIME VARCHAR(16777216)

);

copy into races

from @formula1_stage/races.csv

on_error='continue';

create or replace table formula1.raw.results (

RESULTID NUMBER(38,0),

RACEID NUMBER(38,0),

DRIVERID NUMBER(38,0),

CONSTRUCTORID NUMBER(38,0),

NUMBER NUMBER(38,0),

GRID NUMBER(38,0),

POSITION FLOAT,

POSITIONTEXT VARCHAR(16777216),

POSITIONORDER NUMBER(38,0),

POINTS NUMBER(38,0),

LAPS NUMBER(38,0),

TIME VARCHAR(16777216),

MILLISECONDS NUMBER(38,0),

FASTESTLAP NUMBER(38,0),

RANK NUMBER(38,0),

FASTESTLAPTIME VARCHAR(16777216),

FASTESTLAPSPEED FLOAT,

STATUSID NUMBER(38,0)

);

copy into results

from @formula1_stage/results.csv

on_error='continue';

create or replace table formula1.raw.status (

STATUSID NUMBER(38,0),

STATUS VARCHAR(16777216)

);

copy into status

from @formula1_stage/status.csv

on_error='continue'; -

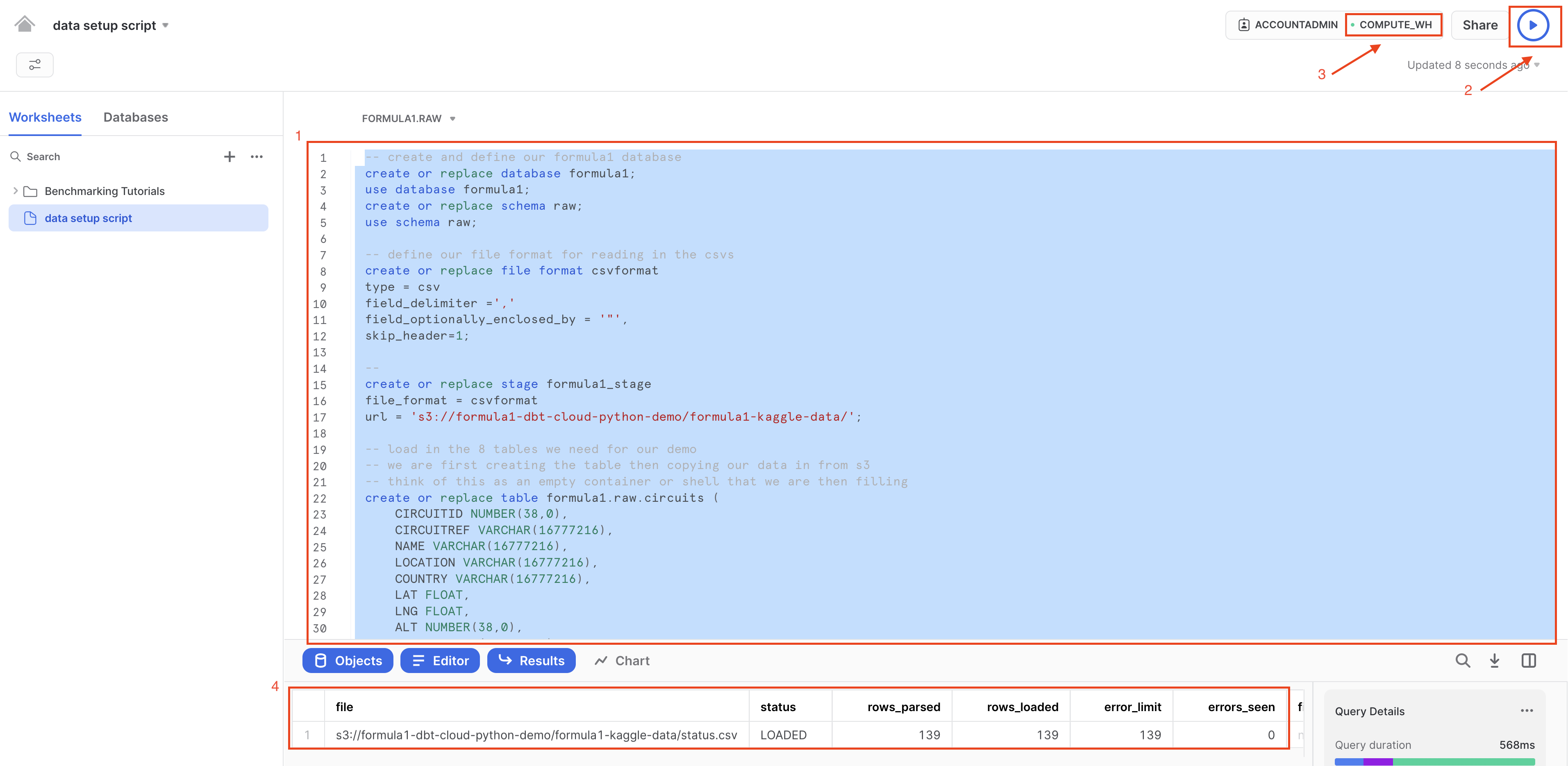

Убедитесь, что все команды выбраны перед выполнением запроса — простой способ сделать это — использовать Ctrl-a, чтобы выделить весь код в листе. Выберите run (синий треугольник). Обратите внимание, как точка рядом с вашим COMPUTE_WH меняется с серого на зеленый, когда вы выполняете запрос. Таблица status является последней из всех 8 загруженных таблиц.

-

Давайте разберём довольно длинный запрос, с которым мы столкнулись, на составные части. Мы выполнили этот запрос, чтобы загрузить наши 8 таблиц Formula 1 из публичного S3‑бакета. Для этого мы:

- Создали новую базу данных с именем

formula1и схемуraw, в которую поместили наши «сырые» (непреобразованные) данные. - Определили формат файлов для наших CSV‑файлов. Важно, что здесь мы используем параметр

field_optionally_enclosed_by =, так как строковые столбцы в наших CSV‑файлах Formula 1 используют кавычки. Кавычки применяются вокруг строковых значений, чтобы избежать проблем с парсингом, когда запятые,и переводы строки/nвнутри значений данных могут вызывать ошибки при загрузке. - Создали stage для указания расположения данных, которые мы собираемся загрузить. Snowflake Stages — это места, где хранятся файлы данных. Stages используются как для загрузки, так и для выгрузки данных в Snowflake и из него. В данном случае мы используем внешний stage, ссылаясь на S3‑бакет.

- Создали таблицы, в которые будут скопированы данные. Это пустые таблицы с заданными именами столбцов и типами данных. Можно представить это как создание пустого контейнера, который затем будет заполнен данными.

- Использовали оператор

copy intoдля каждой из наших таблиц. Мы ссылаемся на созданное staged‑расположение и при возникновении ошибок загрузки продолжаем загружать оставшиеся данные. Ошибок загрузки быть не должно, но если они всё же возникнут, соответствующие строки будут пропущены, а Snowflake сообщит, какие строки вызвали ошибки.

- Создали новую базу данных с именем

-

Теперь давайте посмотрим на наши классные данные Formula 1, которые мы только что загрузили!

-

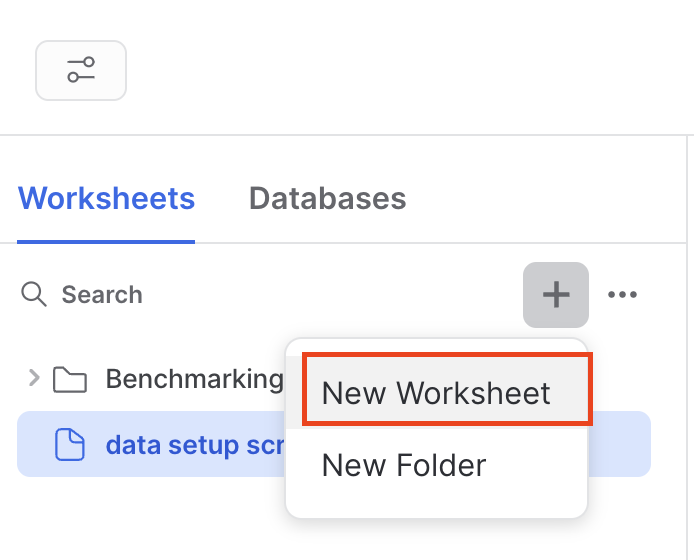

Создайте новый worksheet, выбрав +, затем New Worksheet.

-

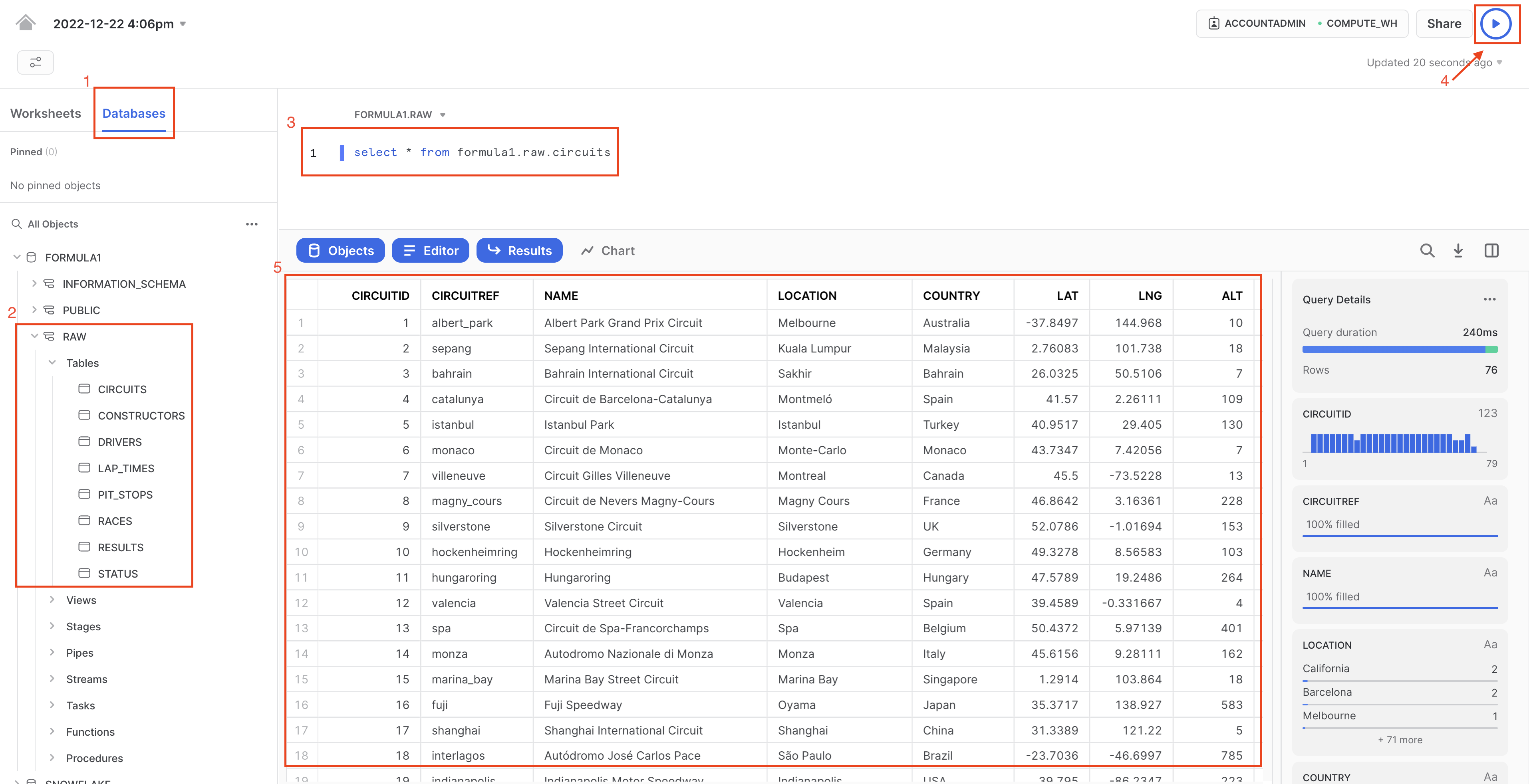

Перейдите в Database > Formula1 > RAW > Tables.

-

Выполните запрос к данным, используя следующий код. В таблице circuits всего 76 строк, поэтому нам не нужно беспокоиться об ограничении объёма запрашиваемых данных.

select * from formula1.raw.circuits

-

-

Выполните запрос. Начиная с этого момента мы будем использовать сочетания клавиш Command-Enter или Control-Enter для запуска запросов и не будем отдельно упоминать этот шаг.

-

Просмотрите результаты запроса: вы должны увидеть информацию о трассах Формулы‑1, начиная с Albert Park в Австралии!

-

Наконец, убедитесь, что у вас есть все 8 таблиц — начиная с

CIRCUITSи заканчиваяSTATUS. Теперь мы готовы подключиться к dbt!

Настройка dbt

-

Мы будем использовать Snowflake Partner Connect для настройки аккаунта dbt. Этот способ позволяет быстро развернуть полностью готовый аккаунт dbt с уже настроенным подключением к Snowflake, управляемым репозиторием, окружениями и учетными данными.

-

Вернитесь из worksheet, выбрав home.

-

В Snowsight убедитесь, что вы используете роль ACCOUNTADMIN.

-

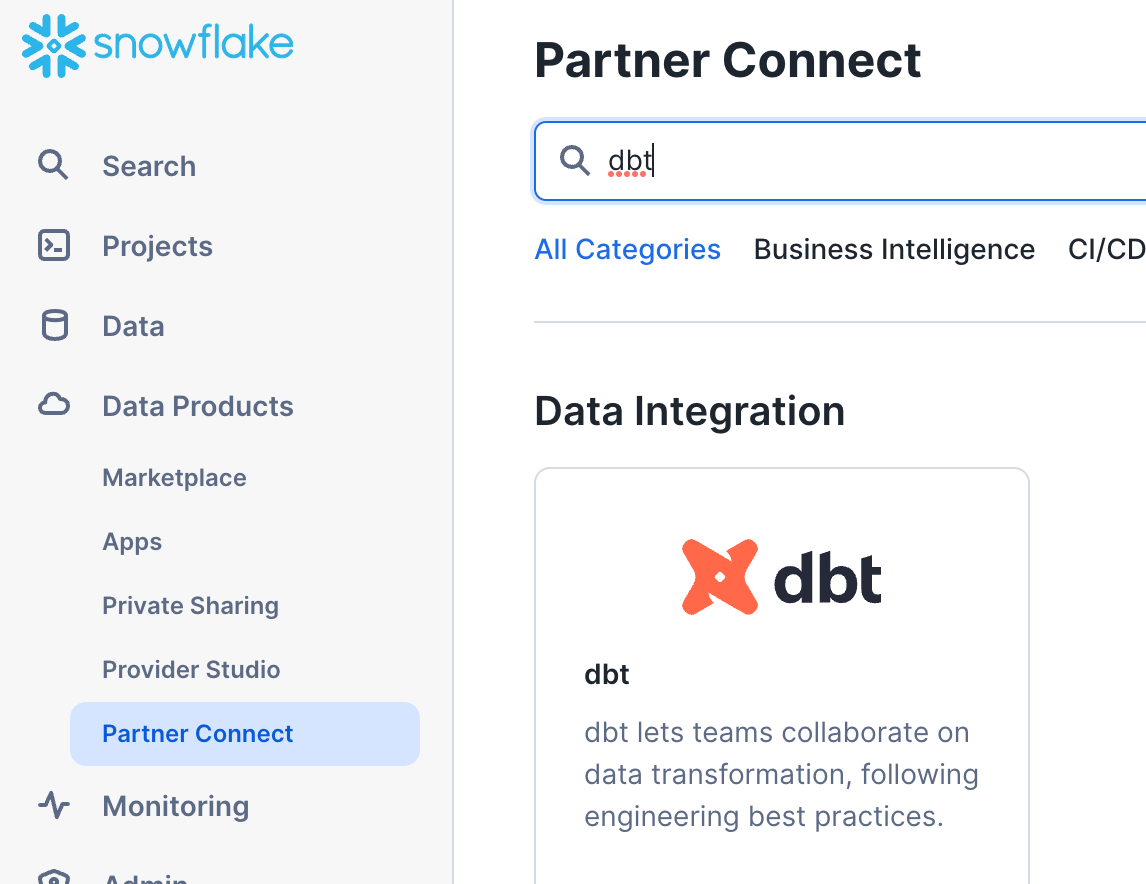

Перейдите в Data Products > Partner Connect. Найдите dbt, используя строку поиска или перейдя в раздел Data Integration. Выберите плитку dbt.

-

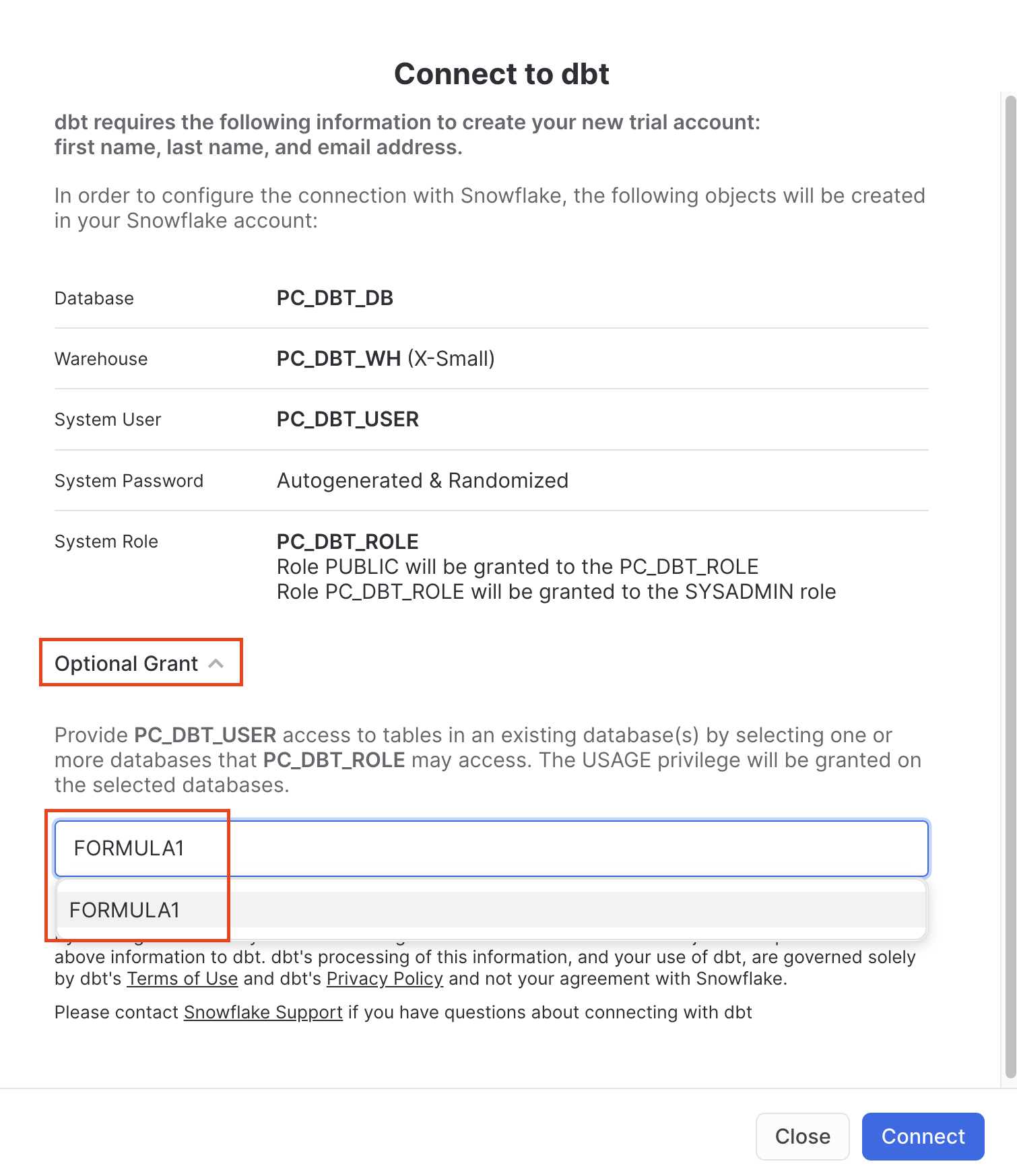

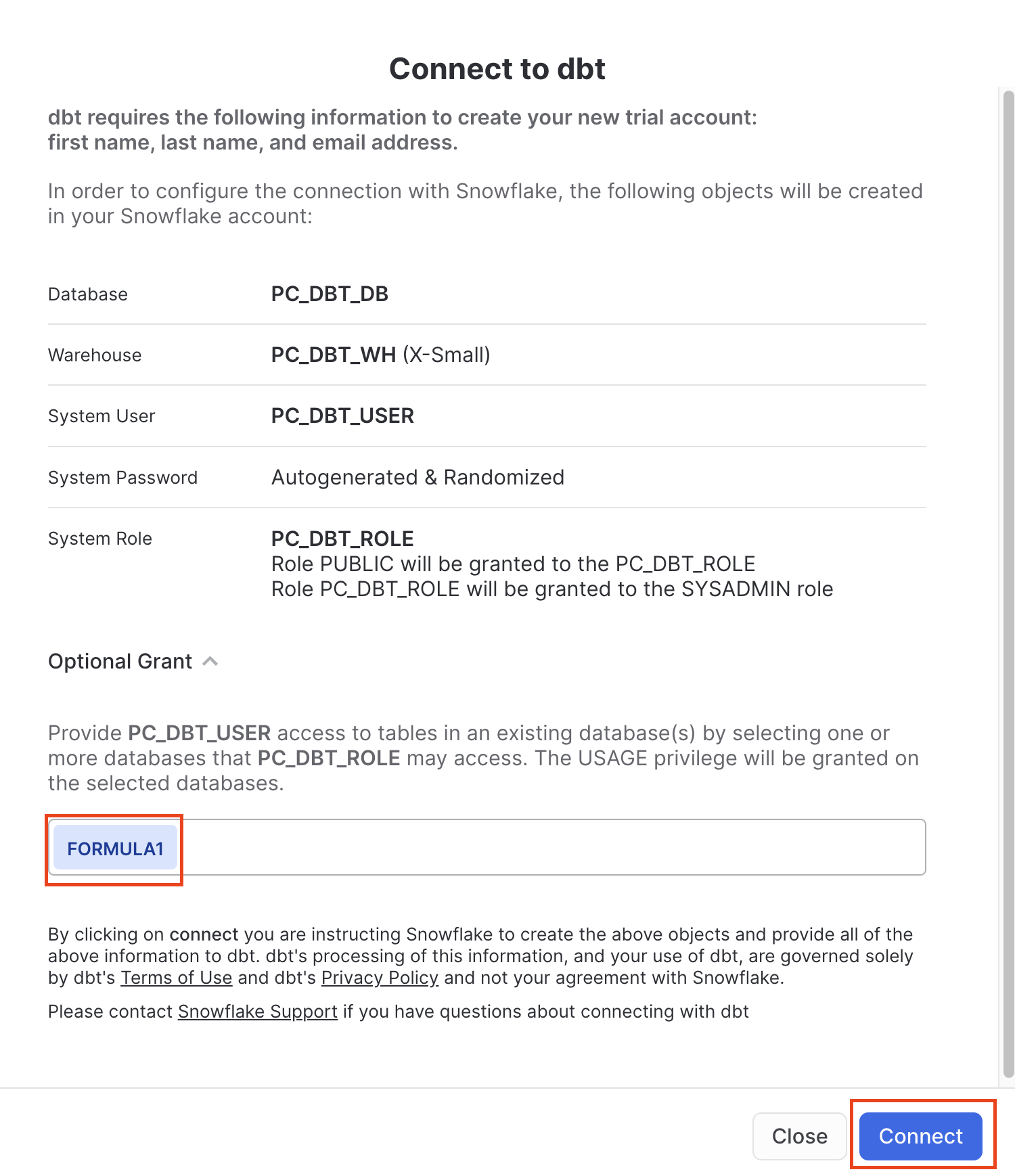

Теперь должно открыться новое окно с заголовком Connect to dbt. Выберите Optional Grant и добавьте базу данных

FORMULA1. Это предоставит новой роли пользователя dbt доступ к базе данных FORMULA1. -

Перед нажатием Connect убедитесь, что

FORMULA1присутствует в списке optional grant. Это действие создаст выделенного пользователя dbt, базу данных, warehouse и роль для вашего пробного аккаунта dbt. -

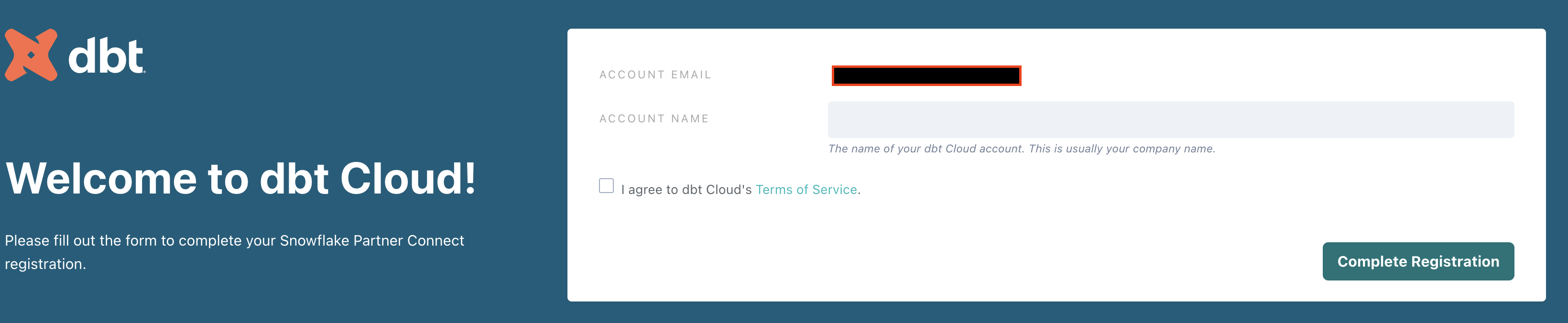

Когда вы увидите окно Your partner account has been created, нажмите Activate.

-

Вы будете перенаправлены на страницу регистрации dbt. Заполните форму. Обязательно сохраните пароль в надежном месте, чтобы в дальнейшем использовать его для входа.

-

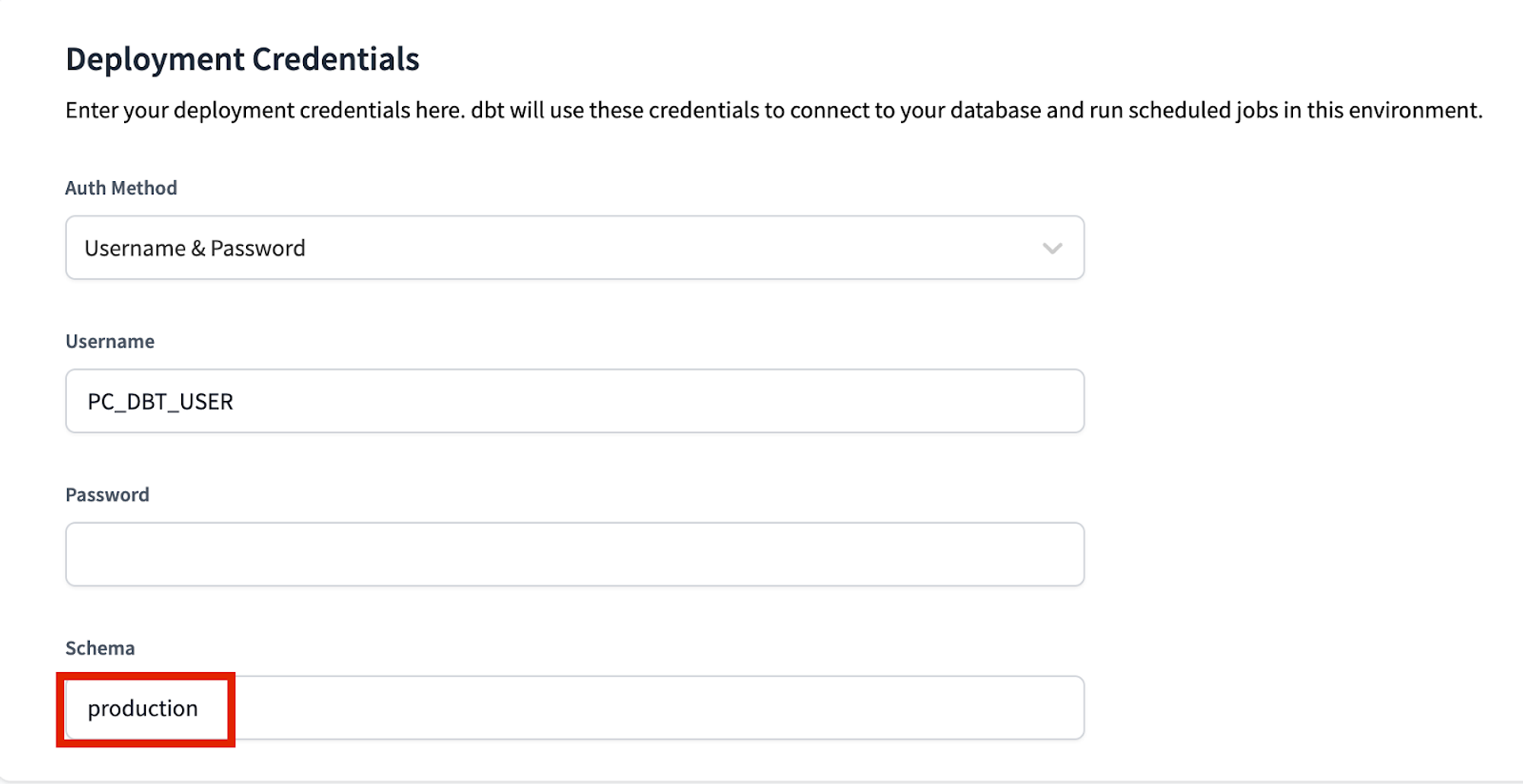

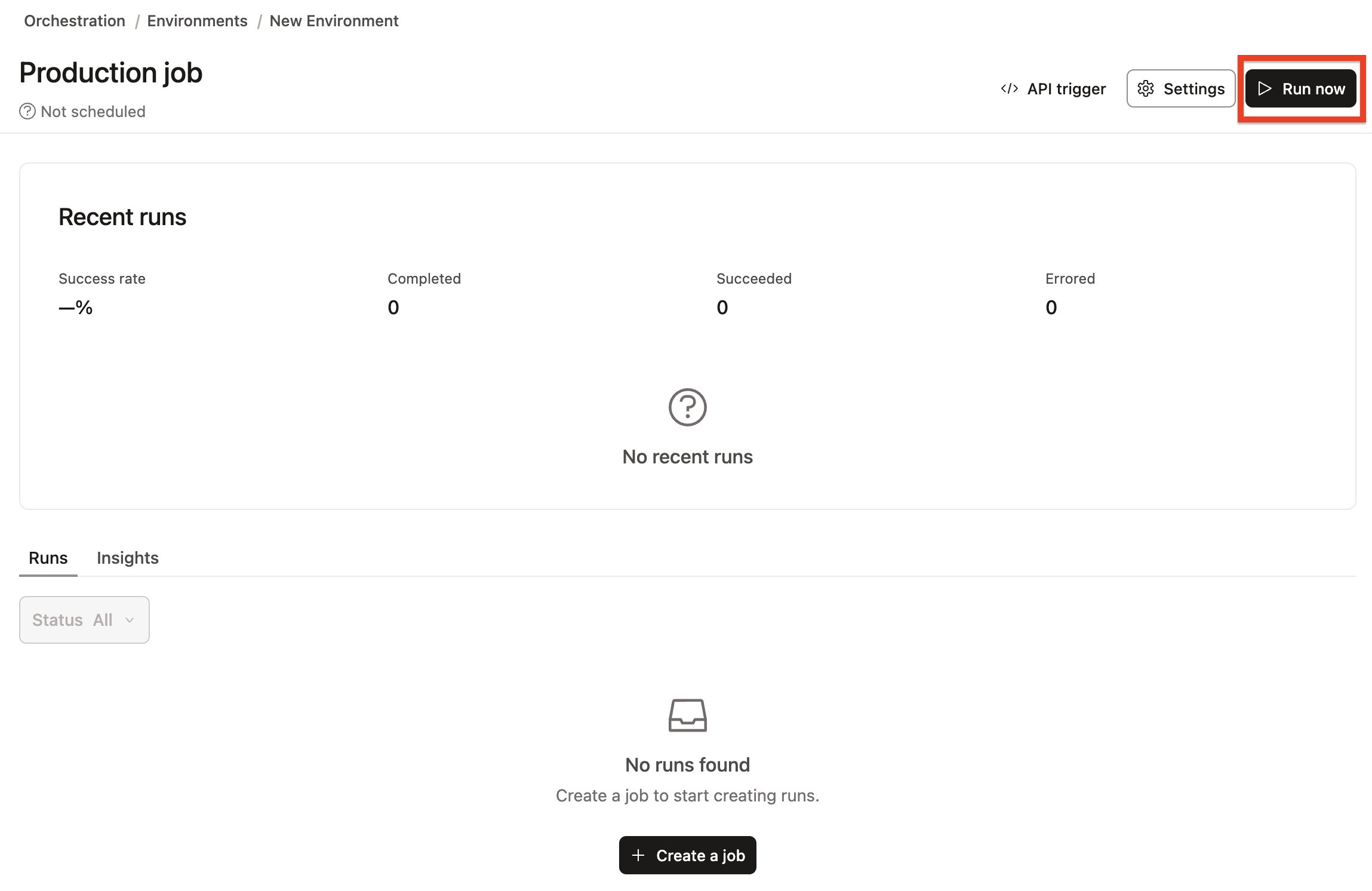

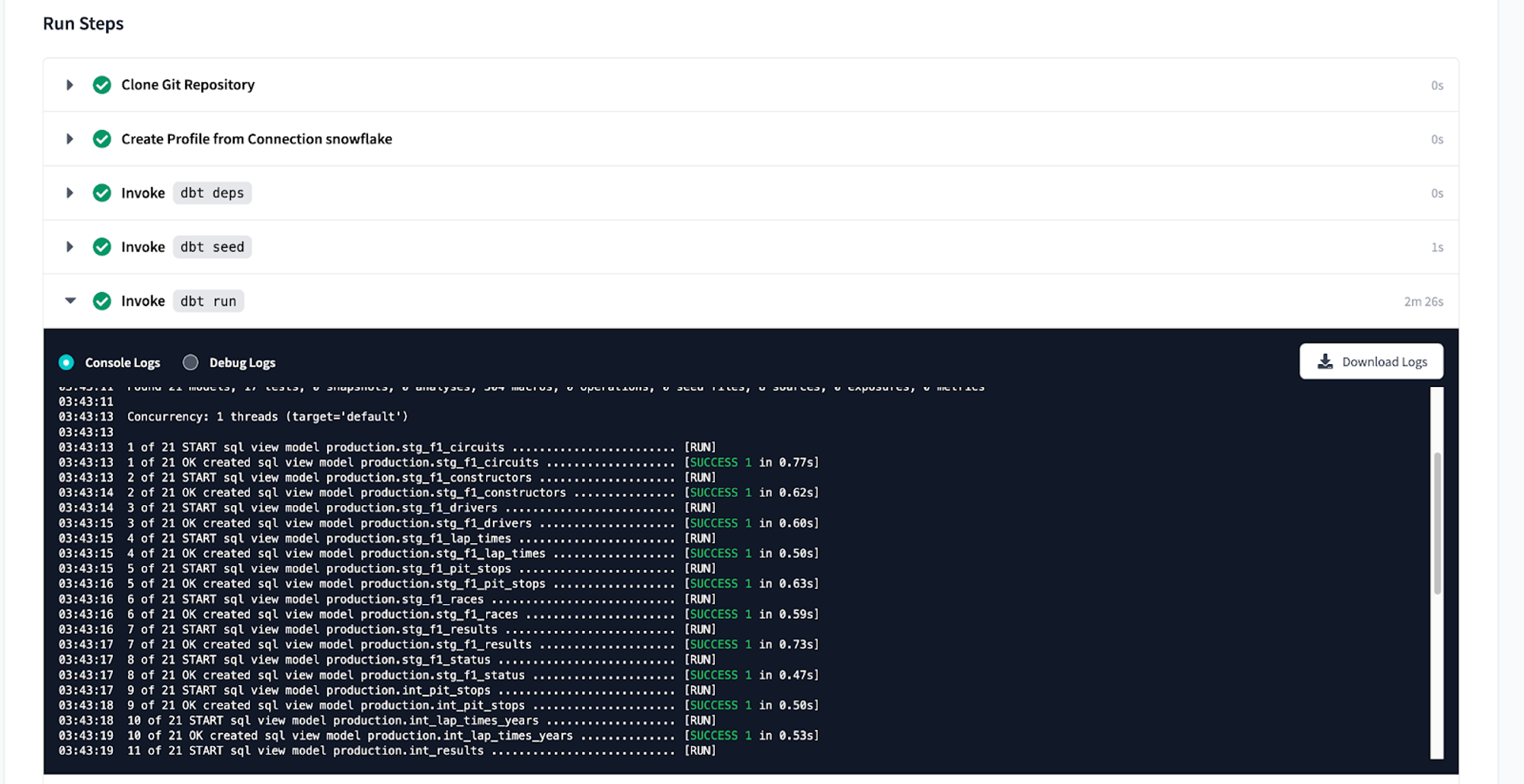

Нажмите Complete Registration. После этого вы будете перенаправлены в свой аккаунт dbt, в котором уже будет настроено подключение к вашему аккаунту Snowflake, создан деплоймент и среда разработки, а также добавлена примерная (sample) job.

-

Чтобы помочь вам с версионированием dbt‑проекта, мы подключили его к managed repository. Это означает, что dbt Labs будет хостить ваш репозиторий за вас. Вы получите доступ к рабочему процессу Git без необходимости самостоятельно создавать и поддерживать репозиторий. Для этого воркшопа вам не нужно знать Git; dbt поможет и проведет вас через весь workflow. В будущем, когда вы будете разрабатывать собственный проект, вы можете использовать свой репозиторий. Это позволит вам подробнее познакомиться с такими возможностями, как сборки Slim CI, уже после этого воркшопа.

Изменение имени схемы разработки и навигация по IDE

-

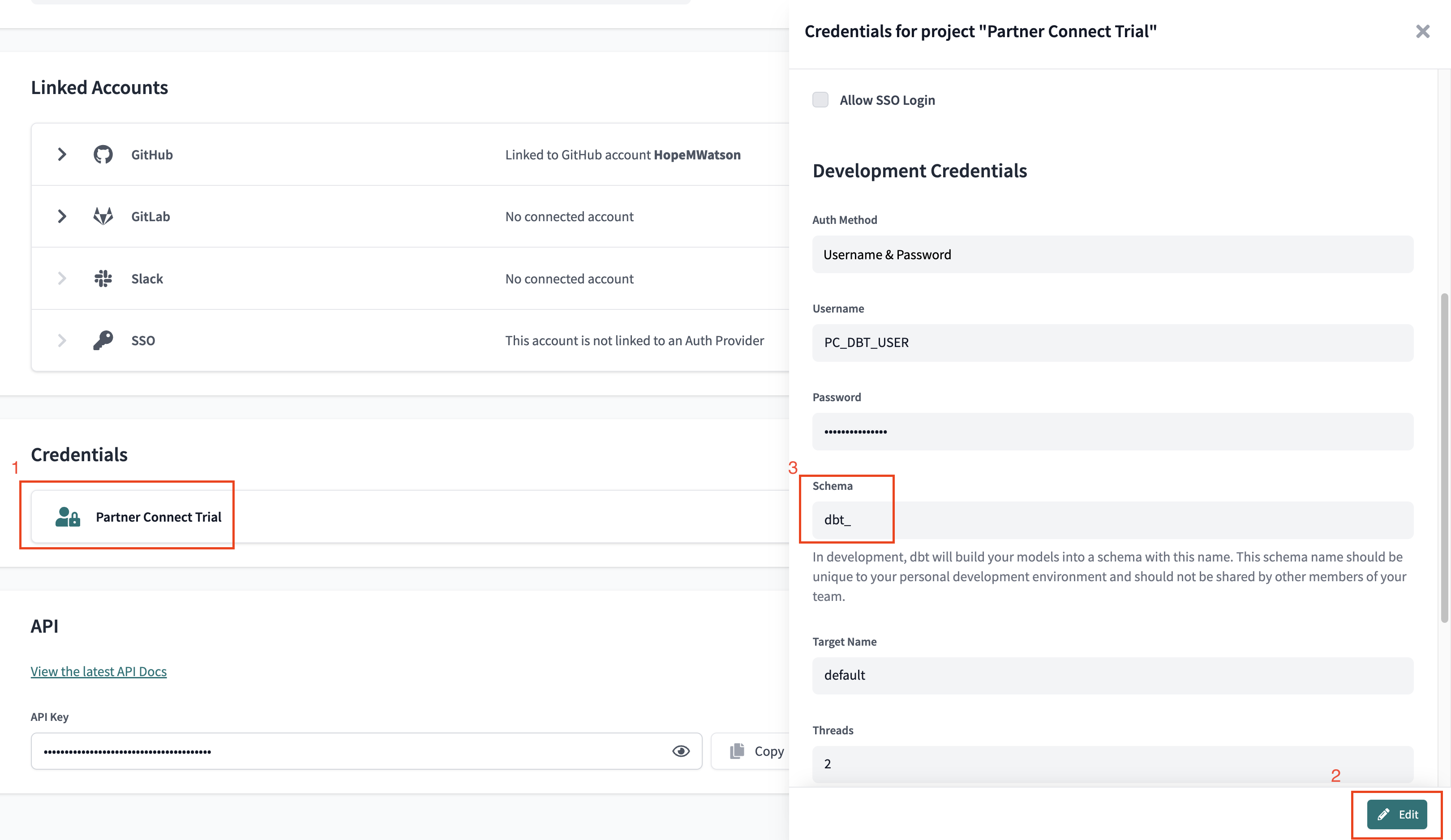

Сначала мы изменим имя нашей схемы по умолчанию, в которой будут строиться наши модели dbt. По умолчанию имя —

dbt_. Мы изменим его наdbt_<ВАШЕ_ИМЯ>, чтобы создать вашу личную схему разработки. Для этого нажмите на свое имя аккаунта в левом меню и выберите Account settings. -

Перейдите в меню Credentials и выберите Partner Connect Trial, чтобы развернуть меню учетных данных.

-

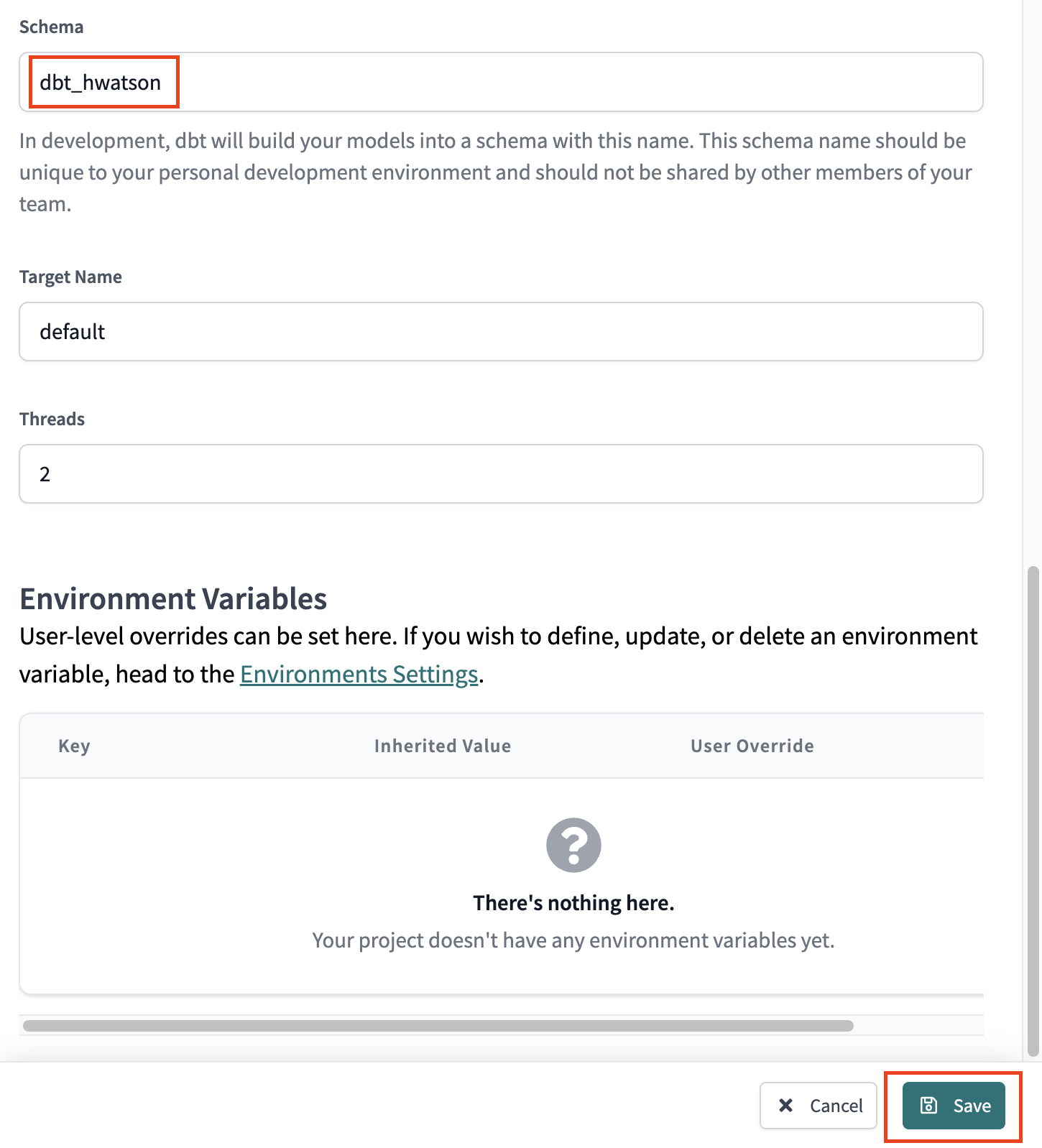

Нажмите Edit и измените имя вашей схемы с

dbt_наdbt_YOUR_NAME, заменивYOUR_NAMEна ваши инициалы и имя. Не забудьте нажать Save, чтобы сохранить изменения! -

Теперь у нас есть собственная персональная схема для разработки — отлично! Когда мы будем запускать наши первые модели dbt, они будут создаваться именно в этой схеме.

-

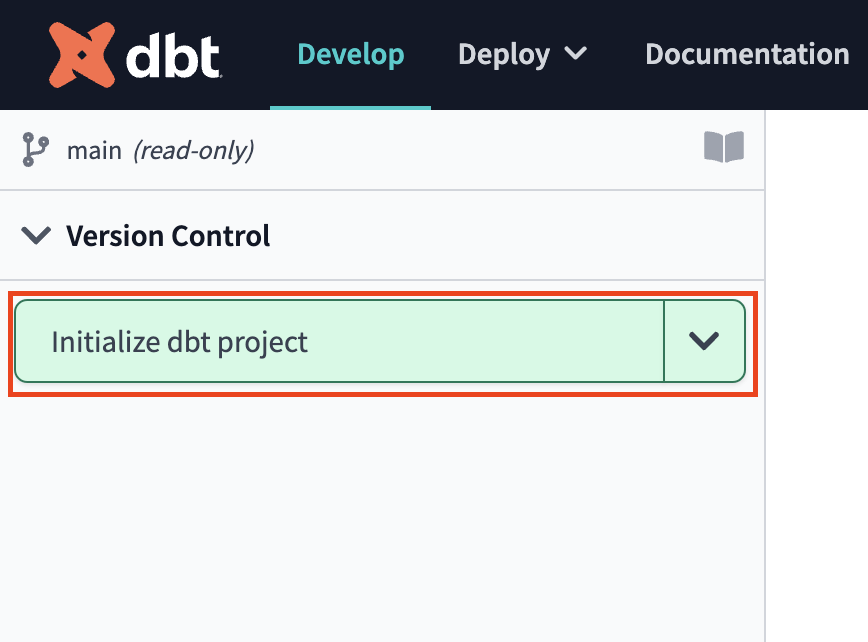

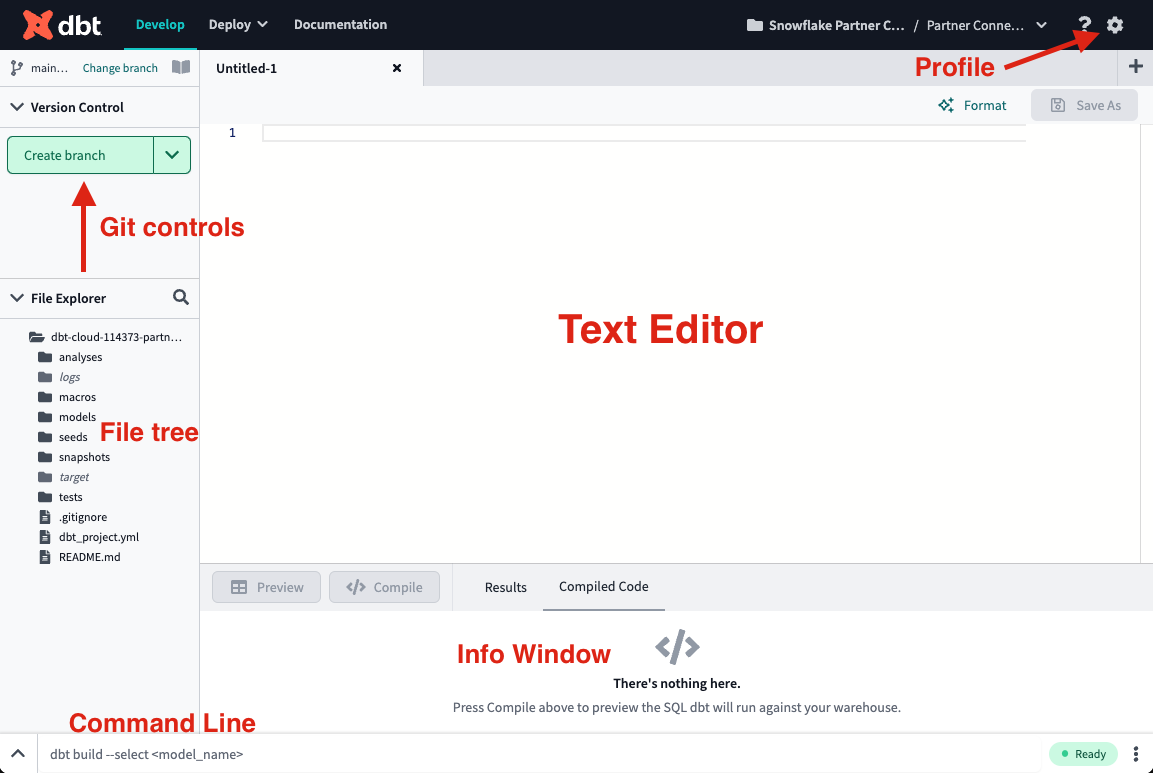

Давайте откроем интегрированную среду разработки dbt (Studio IDE) и немного с ней познакомимся. В верхней части интерфейса выберите Develop.

-

Когда Studio IDE завершит загрузку, нажмите Initialize dbt project. Процесс инициализации создаёт набор файлов и папок, необходимых для запуска вашего dbt‑проекта.

-

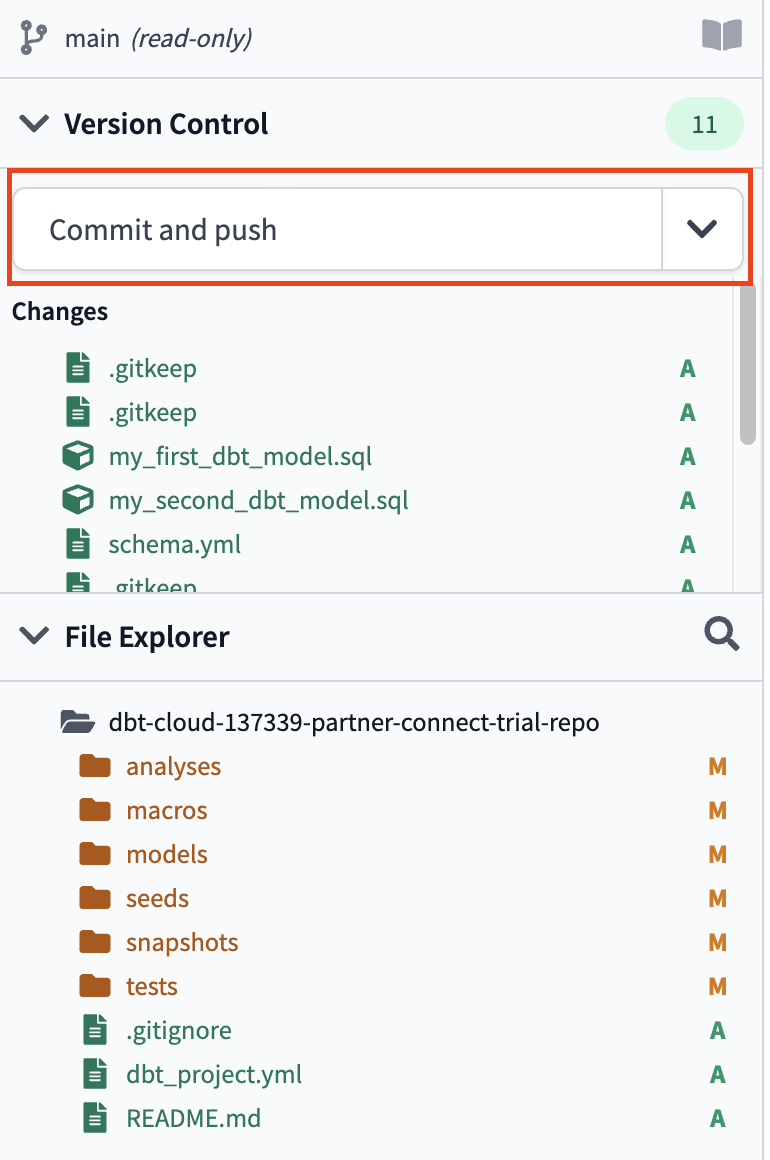

После завершения инициализации вы сможете увидеть файлы и папки в дереве файлов. По мере прохождения воркшопа мы обязательно остановимся на нескольких ключевых файлах и папках, с которыми будем работать при построении проекта.

-

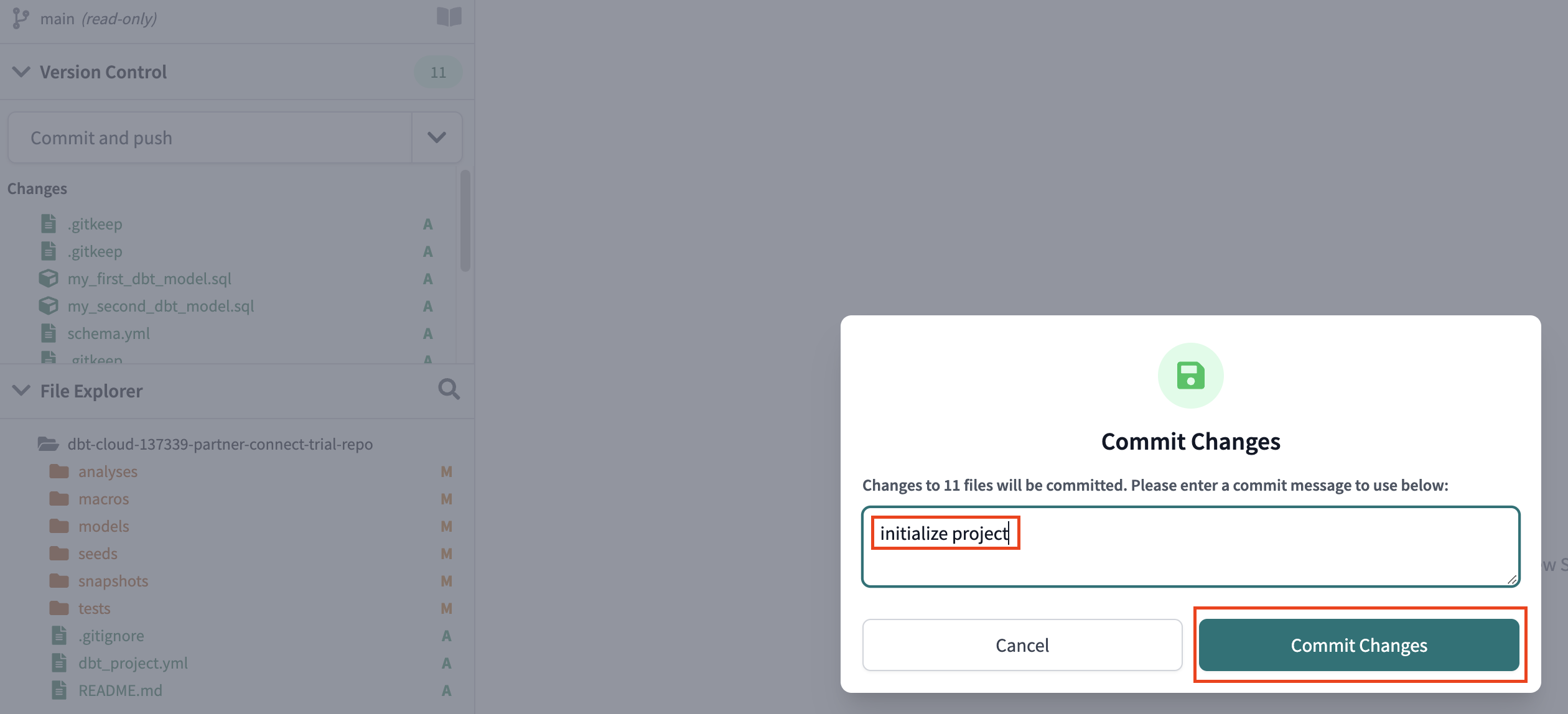

Затем нажмите Commit and sync, чтобы закоммитить новые файлы и папки, созданные на шаге инициализации. Сообщения коммитов всегда должны отражать суть вносимых изменений, поэтому укажите, например, сообщение

initialize projectи выберите Commit Changes. -

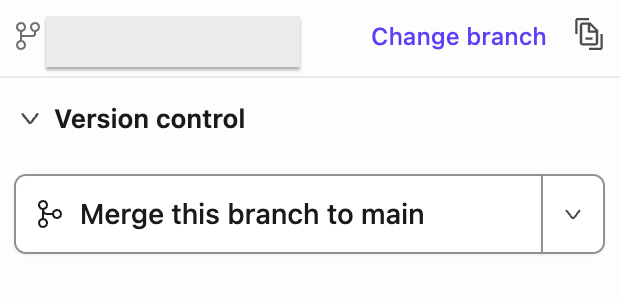

Коммит вашей работы на этом этапе сохранит её в управляемом git‑репозитории, который был создан во время подключения через Partner Connect. Этот начальный коммит — единственный, который будет сделан напрямую в ветку

main; начиная с этого момента вся дальнейшая работа будет вестись в ветке разработки. Это позволяет держать изменения для разработки отдельно от продакшен‑кода. -

Прежде чем приступить к работе, стоит отметить несколько ключевых возможностей Studio IDE. Это текстовый редактор, среда выполнения SQL и Python, а также CLI с поддержкой контроля версий Git — всё в одном инструменте! Это позволяет сосредоточиться на редактировании SQL‑ и Python‑файлов, предварительном просмотре результатов с помощью SQL‑раннера (он даже выполняет Jinja!) и сборке моделей из командной строки без необходимости переключаться между разными приложениями. Git‑workflow в dbt подходит как новичкам, так и опытным пользователям Git, позволяя легко управлять версиями всей работы всего в пару кликов.

-

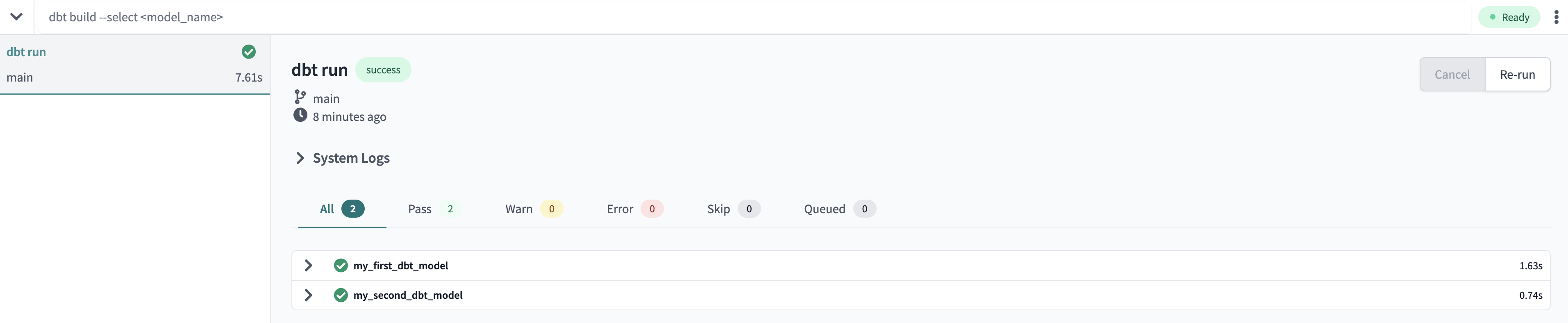

Давайте запустим наши первые модели dbt! В ваш проект dbt включены две примерные модели в папке

models/examples, которые мы можем использовать для иллюстрации того, как запускать dbt в командной строке. Введитеdbt runв командной строке и нажмите Enter на клавиатуре. Когда панель выполнения развернется, вы сможете увидеть результаты выполнения, где вы должны увидеть успешное завершение выполнения. -

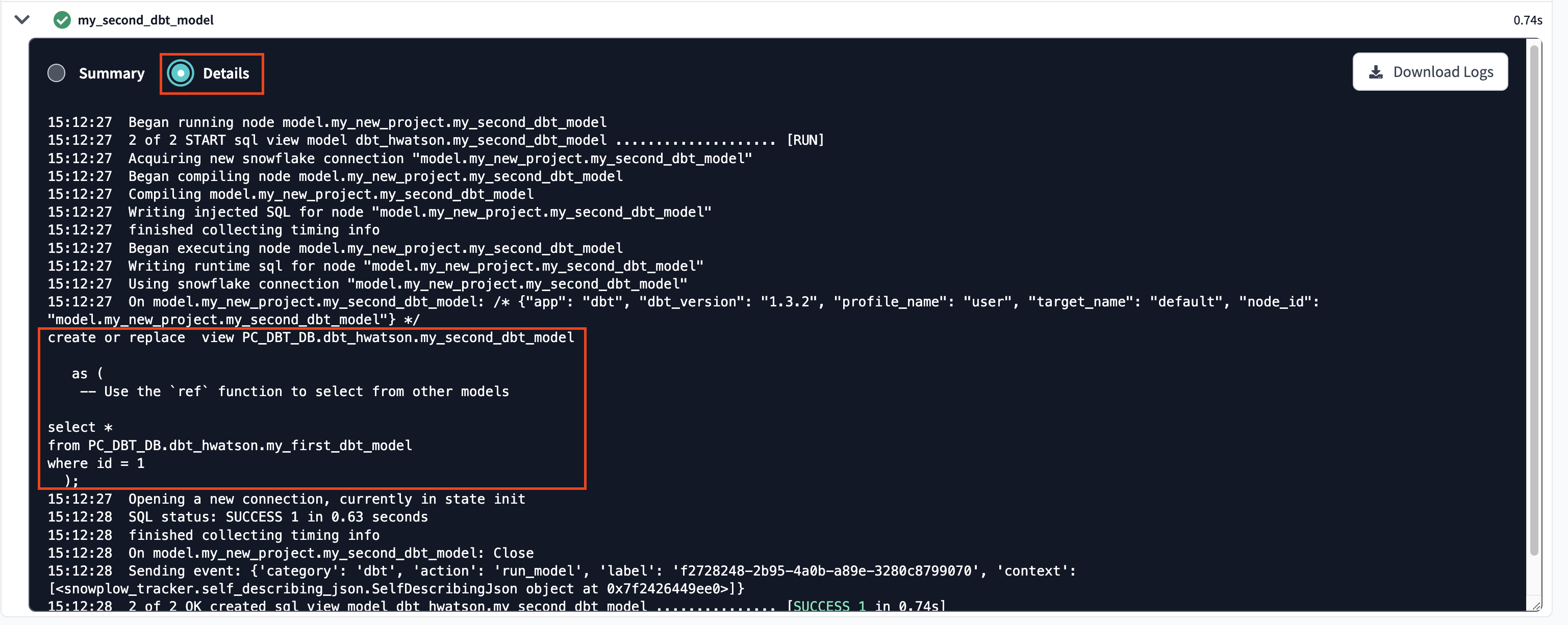

Результаты выполнения позволяют вам увидеть код, который dbt компилирует и отправляет в Snowflake для выполнения. Чтобы просмотреть журналы этого выполнения, выберите одну из вкладок модели, используя значок >, а затем Details. Если вы немного прокрутите вниз, вы сможете увидеть скомпилированный код и то, как dbt взаимодействует с Snowflake. Поскольку это выполнение происходило в нашей среде разработки, модели были созданы в вашей схеме разработки.

-

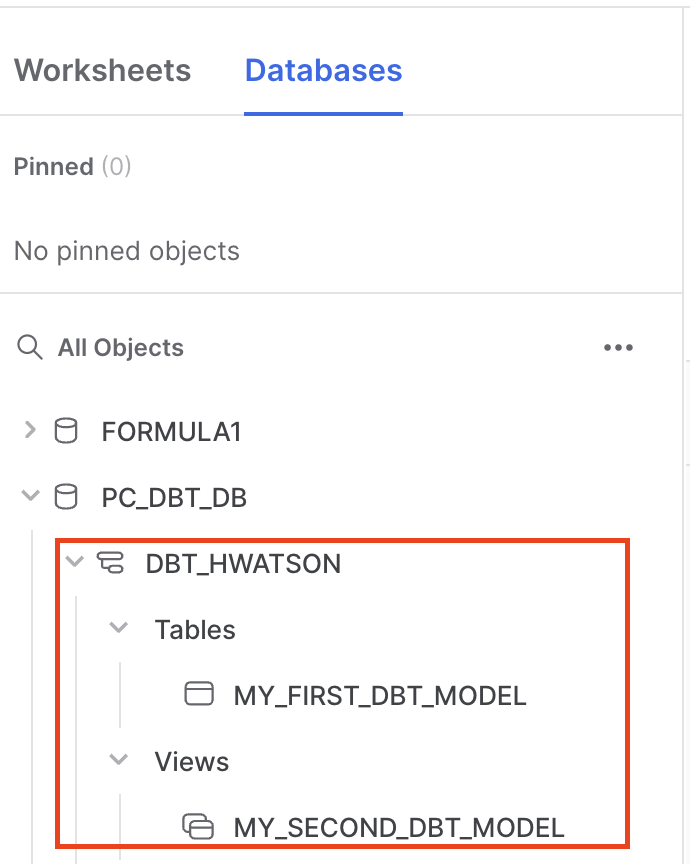

Теперь давайте переключимся в Snowflake, чтобы убедиться, что объекты действительно были созданы. Нажмите на три точки … над объектами вашей базы данных, а затем выберите Refresh. Разверните базу данных PC_DBT_DB, и вы должны увидеть свою схему разработки. Выберите эту схему, затем Tables и Views. Теперь вы должны увидеть

MY_FIRST_DBT_MODELкак таблицу иMY_SECOND_DBT_MODELкак представление.

Создание ветки и настройка конфигураций проекта

На этом этапе нам нужно создать ветку разработки и настроить конфигурации на уровне проекта.

-

Чтобы начать разработку нашего проекта, нам нужно создать новую ветку Git для нашей работы. Выберите create branch и назовите вашу ветку разработки. Мы назовем нашу ветку

snowpark_python_workshop, затем нажмите Submit. -

Первым шагом в разработке проекта будет обновление файла

dbt_project.yml. Каждый проект dbt требует наличия файлаdbt_project.yml— это то, как dbt узнает, что каталог является проектом dbt. Файл dbt_project.yml также содержит важную информацию, которая сообщает dbt, как работать с вашим проектом. -

Выберите файл

dbt_project.ymlиз дерева файлов, чтобы открыть его, и замените все существующее содержимое следующим кодом. Когда закончите, сохраните файл, нажав save. Вы также можете использовать сочетание клавиш Command-S или Control-S с этого момента.# Назовите ваш проект! Имена проектов должны содержать только строчные символы

# и подчеркивания. Хорошее имя пакета должно отражать название вашей организации

# или предполагаемое использование этих моделей

name: 'snowflake_dbt_python_formula1'

version: '1.3.0'

require-dbt-version: '>=1.3.0'

config-version: 2

# Эта настройка конфигурирует, какой "профиль" dbt использует для этого проекта.

profile: 'default'

# Эти конфигурации указывают, где dbt должен искать различные типы файлов.

# Конфигурация `model-paths`, например, указывает, что модели в этом проекте можно

# найти в каталоге "models/". Вероятно, вам не нужно будет их изменять!

model-paths: ["models"]

analysis-paths: ["analyses"]

test-paths: ["tests"]

seed-paths: ["seeds"]

macro-paths: ["macros"]

snapshot-paths: ["snapshots"]

target-path: "target" # каталог, который будет хранить скомпилированные SQL файлы

clean-targets: # каталоги, которые будут удалены командой `dbt clean`

- "target"

- "dbt_packages"

models:

snowflake_dbt_python_formula1:

staging:

+docs:

node_color: "CadetBlue"

marts:

+materialized: table

aggregates:

+docs:

node_color: "Maroon"

+tags: "bi"

core:

+docs:

node_color: "#800080"

intermediate:

+docs:

node_color: "MediumSlateBlue"

ml:

prep:

+docs:

node_color: "Indigo"

train_predict:

+docs:

node_color: "#36454f" -

Основные конфигурации, на которые стоит обратить внимание в файле в отношении работы, которую мы собираемся выполнить, находятся в разделе

models.require-dbt-version— Указывает dbt, какую версию dbt использовать для вашего проекта. Мы требуем 1.3.0 и любую более новую версию для запуска python моделей и цветов узлов.materialized— Указывает dbt, как материализовать модели при компиляции кода перед его отправкой в Snowflake. Все модели в папкеmartsбудут построены как таблицы.tags— Применяет теги на уровне каталога ко всем моделям. Все модели в папкеaggregatesбудут помечены какbi(сокращение от business intelligence).docs— Указываетnode_colorлибо по имени цвета, либо по значению hex.

-

Материализации — это стратегии для сохранения моделей dbt в хранилище, с

tablesиviewsкак наиболее часто используемыми типами. По умолчанию все модели dbt материализуются как представления, и другие типы материализации могут быть настроены в файлеdbt_project.ymlили в самой модели. Очень важно отметить, что Python модели могут быть материализованы только как таблицы или инкрементальные модели. Поскольку все наши Python модели находятся вmarts, следующая часть нашегоdbt_project.ymlгарантирует, что не возникнет ошибок при запуске наших Python моделей. Начиная с версии dbt 1.4, Python файлы автоматически материализуются как таблицы, даже если это не указано явно.marts:

+materialized: table

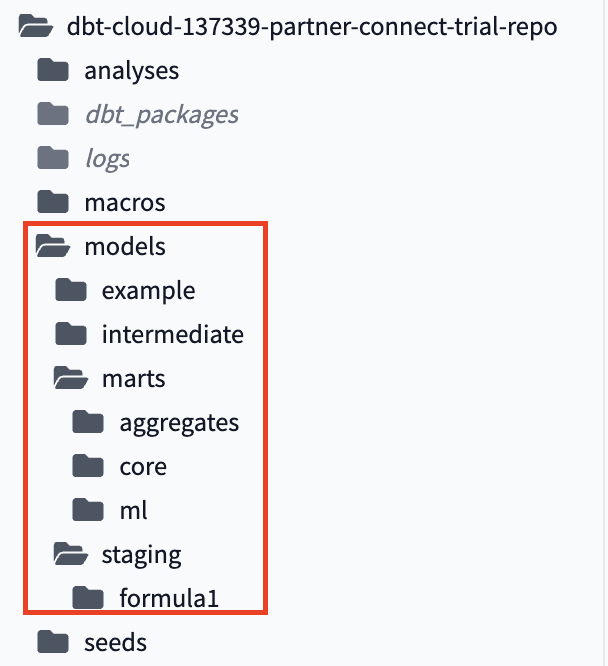

Создание папок и организация файлов

dbt Labs разработала руководство по структуре проекта, которое содержит ряд рекомендаций по построению структуры папок для вашего проекта. Обязательно ознакомьтесь с этим руководством, если хотите узнать больше. Сейчас мы создадим несколько папок для организации наших файлов:

- Sources — Это наш датасет Formula 1, который будет определён в YAML‑файле с описанием источников (source properties).

- Staging models — Эти модели находятся в отношении 1:1 со своими исходными таблицами.

- Intermediate — Здесь мы будем выполнять объединения (joins) некоторых staging‑моделей Formula.

- Marts models — Здесь выполняются основные трансформации. Этот слой содержит следующие подпапки:

- aggregates

- core

- ml

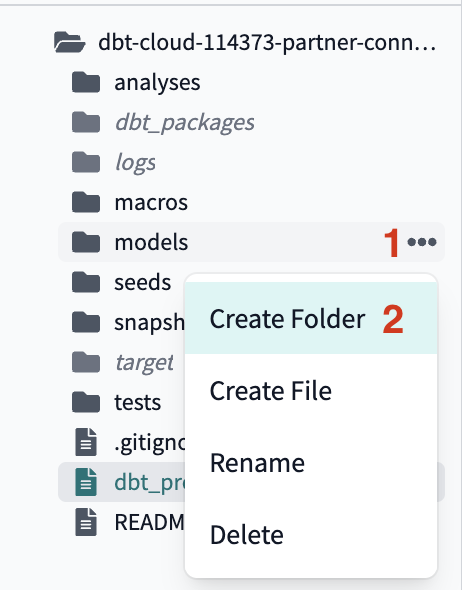

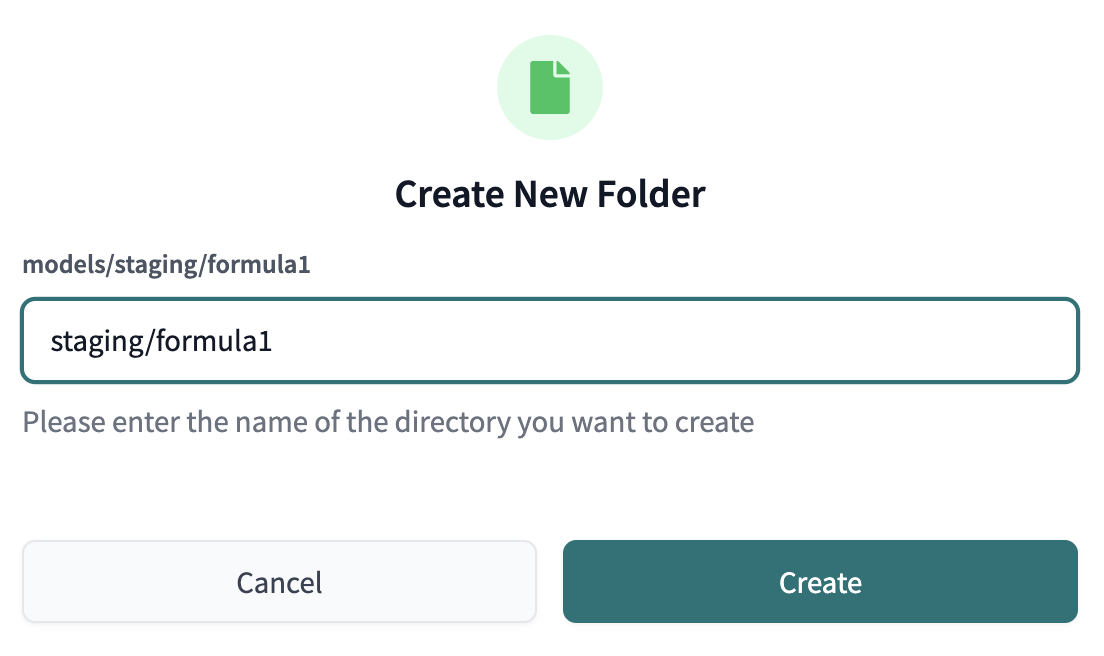

- В вашем дереве файлов используйте курсор и наведите на подкаталог

models, нажмите на три точки …, которые появятся справа от имени папки, затем выберите Create Folder. Мы добавим две новые папки в путь к файлу,stagingиformula1(в этом порядке), введяstaging/formula1в путь к файлу.

- Если вы откроете свой каталог

modelsсейчас, вы должны увидеть новую папкуstaging, вложенную вmodels, и папкуformula1, вложенную вstaging.

-

Создайте две дополнительные папки так же, как и на предыдущем шаге. В подкаталоге

modelsсоздайте новые каталогиmarts/core. -

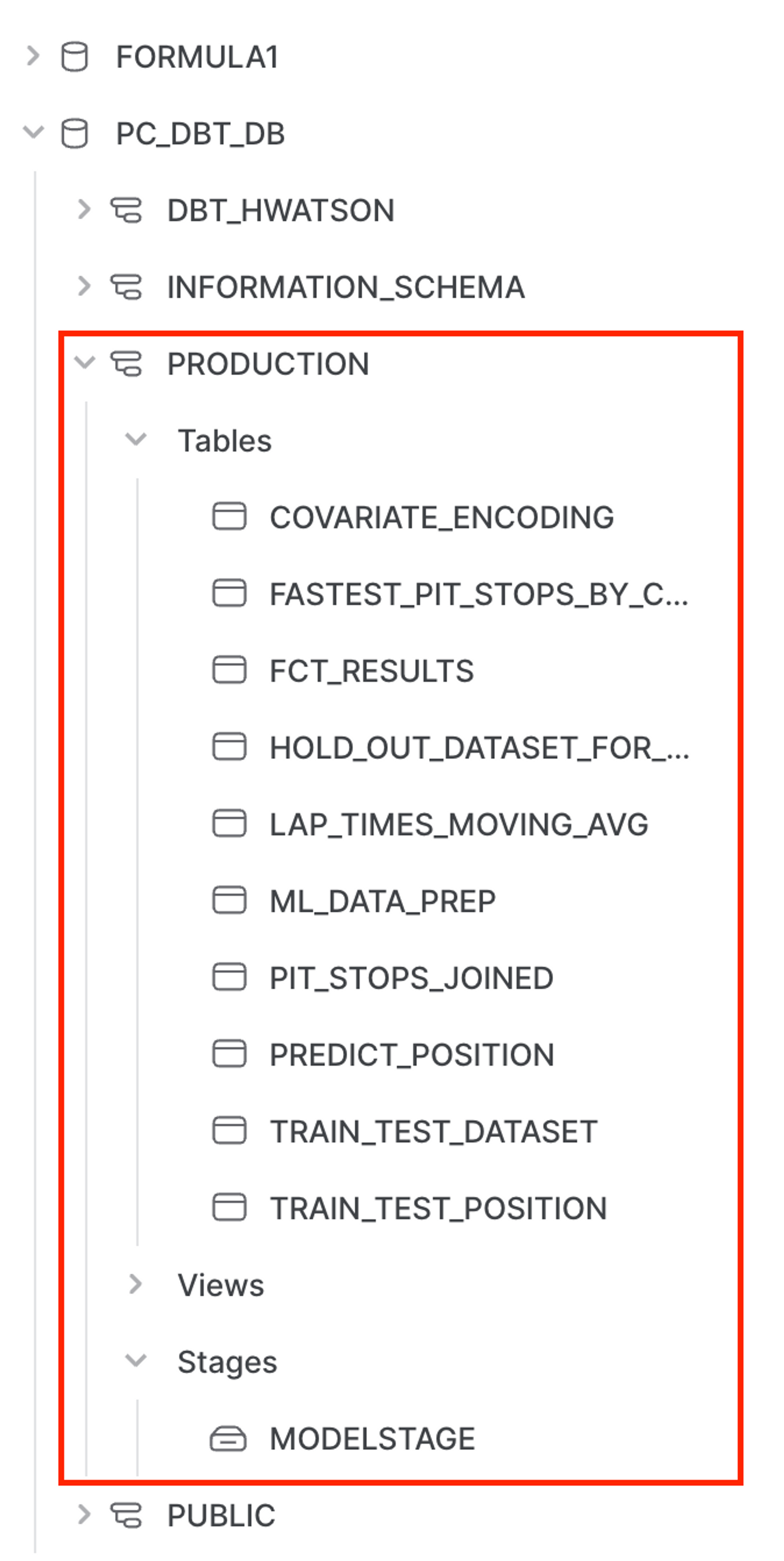

Нам нужно будет создать еще несколько папок и подпапок с помощью интерфейса. После того, как вы создадите все необходимые папки, ваше дерево папок должно выглядеть так, когда все будет готово:

Помните, что вы всегда можете обратиться к полному проекту на GitHub, чтобы просмотреть полную структуру папок и файлов.

Создание источников и моделей подготовки

В этом разделе мы создадим наши источники и модели подготовки.

Источники позволяют нам создать зависимость между нашим исходным объектом базы данных и нашими моделями подготовки, что поможет нам, когда мы будем смотреть на data lineage позже. Кроме того, если ваш источник изменяет базу данных или схему, вам нужно будет обновить его только в вашем файле f1_sources.yml, а не обновлять все модели, в которых он может использоваться.

Модели подготовки являются основой нашего проекта, где мы собираем все отдельные компоненты, которые мы будем использовать для создания наших более сложных и полезных моделей в проект.

Поскольку мы хотим сосредоточиться на dbt и Python в этом воркшопе, ознакомьтесь с нашими источниками и документами по подготовке, если хотите узнать больше (или пройдите наш курс dbt Fundamentals, который охватывает все наши основные функции).

1. Создание источников

Мы будем использовать каждую из наших 8 таблиц Формулы 1 из нашей базы данных formula1 под схемой raw для наших преобразований, и мы хотим создать эти таблицы как источники в нашем проекте.

- Создайте новый файл с именем

f1_sources.ymlс следующим путем к файлу:models/staging/formula1/f1_sources.yml. - Затем вставьте следующий код в файл перед его сохранением:

version: 2

sources:

- name: formula1

description: формула 1 наборы данных с нормализованными таблицами

database: formula1

schema: raw

tables:

- name: circuits

description: Одна запись на трассу, которая является конкретной гоночной трассой.

columns:

- name: circuitid

data_tests:

- unique

- not_null

- name: constructors

description: Одна запись на конструктора. Конструкторы — это команды, которые строят свои автомобили Формулы 1.

columns:

- name: constructorid

data_tests:

- unique

- not_null

- name: drivers

description: Одна запись на водителя. Эта таблица содержит информацию о водителе.

columns:

- name: driverid

data_tests:

- unique

- not_null

- name: lap_times

description: Одна строка на круг в каждой гонке. Время круга начало записываться в этом наборе данных в 1984 году и соединяется через driver_id.

- name: pit_stops

description: Одна строка на пит-стоп. Пит-стопы не имеют собственного столбца id, комбинация race_id и driver_id идентифицирует пит-стоп.

columns:

- name: stop

data_tests:

- accepted_values:

arguments: # available in v1.10.5 and higher. Older versions can set the <argument_name> as the top-level property.

values: [1,2,3,4,5,6,7,8]

quote: false

- name: races

description: Одна гонка на строку. Важно, что эта таблица содержит год гонки для понимания тенденций.

columns:

- name: raceid

data_tests:

- unique

- not_null

- name: results

columns:

- name: resultid

data_tests:

- unique

- not_null

description: Одна строка на результат. Основная таблица, которую мы соединяем для переменных сетки и позиции.

- name: status

description: Один статус на строку. Статус контекстуализирует, была ли гонка завершена или какие проблемы возникли, например, столкновения, двигатель и т.д.

columns:

- name: statusid

data_tests:

- unique

- not_null

2. Создание моделей подготовки

Следующим шагом будет настройка моделей подготовки для каждой из 8 исходных таблиц. Учитывая отношение один к одному между моделями подготовки и их соответствующими исходными таблицами, мы создадим здесь 8 моделей подготовки. Мы знаем, что это много, и в будущем мы постараемся обновить воркшоп, чтобы сделать этот шаг менее повторяющимся и более эффективным. Этот шаг также является хорошим представлением реального мира данных, где у вас есть несколько иерархических таблиц, которые вам нужно будет объединить!

-

Давайте пойдем в алфавитном порядке, чтобы легко отслеживать все наши модели подготовки! Создайте новый файл с именем

stg_f1_circuits.sqlс этим путем к файлуmodels/staging/formula1/stg_f1_circuits.sql. Затем вставьте следующий код в файл перед его сохранением:with

source as (

select * from {{ source('formula1','circuits') }}

),

renamed as (

select

circuitid as circuit_id,

circuitref as circuit_ref,

name as circuit_name,

location,

country,

lat as latitude,

lng as longitude,

alt as altitude

-- omit the url

from source

)

select * from renamedВсе, что мы делаем здесь, это извлекаем исходные данные в модель, используя функцию

source, переименовываем некоторые столбцы и пропускаем столбецurlс комментарием, так как он нам не нужен для нашего анализа. -

Создайте

stg_f1_constructors.sqlс этим путем к файлуmodels/staging/formula1/stg_f1_constructors.sql. Вставьте следующий код в него перед сохранением файла:with

source as (

select * from {{ source('formula1','constructors') }}

),

renamed as (

select

constructorid as constructor_id,

constructorref as constructor_ref,

name as constructor_name,

nationality as constructor_nationality

-- omit the url

from source

)

select * from renamedУ нас есть еще 6 моделей подготовки, которые нужно создать. Мы можем сделать это, создавая новые файлы, а затем копируя и вставляя код в нашу папку

staging. -

Создайте

stg_f1_drivers.sqlс этим путем к файлуmodels/staging/formula1/stg_f1_drivers.sql:with

source as (

select * from {{ source('formula1','drivers') }}

),

renamed as (

select

driverid as driver_id,

driverref as driver_ref,

number as driver_number,

code as driver_code,

forename,

surname,

dob as date_of_birth,

nationality as driver_nationality

-- omit the url

from source

)

select * from renamed -

Создайте

stg_f1_lap_times.sqlс этим путем к файлуmodels/staging/formula1/stg_f1_lap_times.sql:with

source as (

select * from {{ source('formula1','lap_times') }}

),

renamed as (

select

raceid as race_id,

driverid as driver_id,

lap,

position,

time as lap_time_formatted,

milliseconds as lap_time_milliseconds

from source

)

select * from renamed -

Создайте

stg_f1_pit_stops.sqlс этим путем к файлуmodels/staging/formula1/stg_f1_pit_stops.sql:with

source as (

select * from {{ source('formula1','pit_stops') }}

),

renamed as (

select

raceid as race_id,

driverid as driver_id,

stop as stop_number,

lap,

time as lap_time_formatted,

duration as pit_stop_duration_seconds,

milliseconds as pit_stop_milliseconds

from source

)

select * from renamed

order by pit_stop_duration_seconds desc -

Создайте

stg_f1_races.sqlс этим путем к файлуmodels/staging/formula1/stg_f1_races.sql:with

source as (

select * from {{ source('formula1','races') }}

),

renamed as (

select

raceid as race_id,

year as race_year,

round as race_round,

circuitid as circuit_id,

name as circuit_name,

date as race_date,

to_time(time) as race_time,

-- omit the url

fp1_date as free_practice_1_date,

fp1_time as free_practice_1_time,

fp2_date as free_practice_2_date,

fp2_time as free_practice_2_time,

fp3_date as free_practice_3_date,

fp3_time as free_practice_3_time,

quali_date as qualifying_date,

quali_time as qualifying_time,

sprint_date,

sprint_time

from source

)

select * from renamed -

Создайте

stg_f1_results.sqlс этим путем к файлуmodels/staging/formula1/stg_f1_results.sql:with

source as (

select * from {{ source('formula1','results') }}

),

renamed as (

select

resultid as result_id,

raceid as race_id,

driverid as driver_id,

constructorid as constructor_id,

number as driver_number,

grid,

position::int as position,

positiontext as position_text,

positionorder as position_order,

points,

laps,

time as results_time_formatted,

milliseconds as results_milliseconds,

fastestlap as fastest_lap,

rank as results_rank,

fastestlaptime as fastest_lap_time_formatted,

fastestlapspeed::decimal(6,3) as fastest_lap_speed,

statusid as status_id

from source

)

select * from renamed -

Последний! Создайте

stg_f1_status.sqlс этим путем к файлу:models/staging/formula1/stg_f1_status.sql:with

source as (

select * from {{ source('formula1','status') }}

),

renamed as (

select

statusid as status_id,

status

from source

)

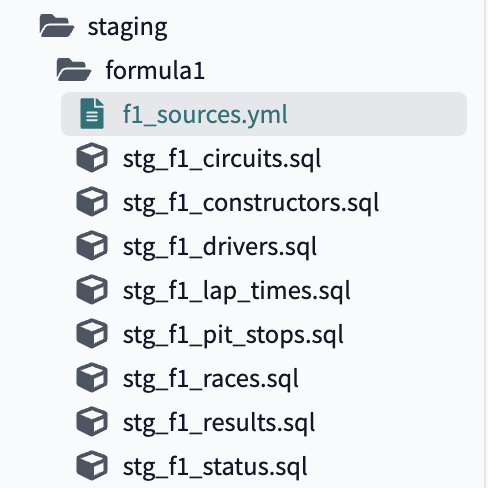

select * from renamedПосле завершения создания источника и всех моделей подготовки для каждой из 8 таблиц ваша папка подготовки должна выглядеть так:

-

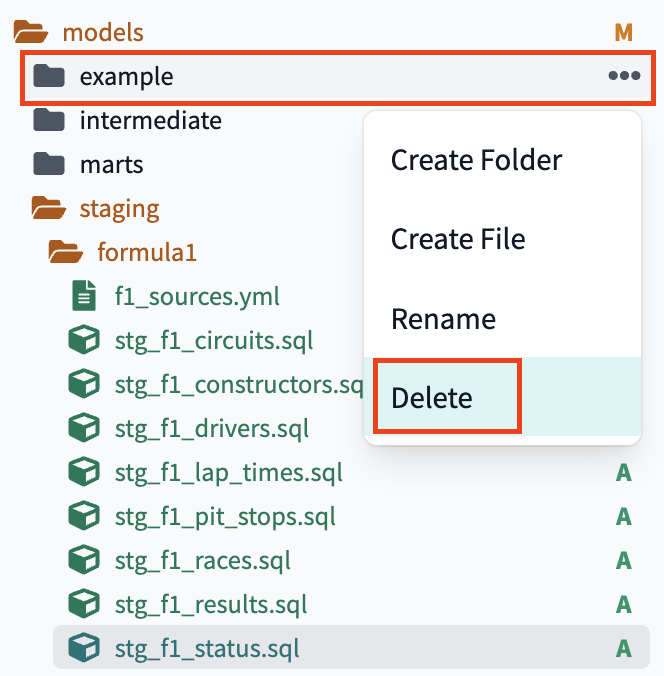

Сейчас подходящий момент удалить примерную папку, так как эти две модели являются лишними для нашего пайплайна

formula1, аmy_first_modelне проходит тестnot_null, разбираться с которым мы не будем. dbt предупредит нас, что эта папка будет удалена безвозвратно — нас это устраивает, поэтому выбираем Delete. -

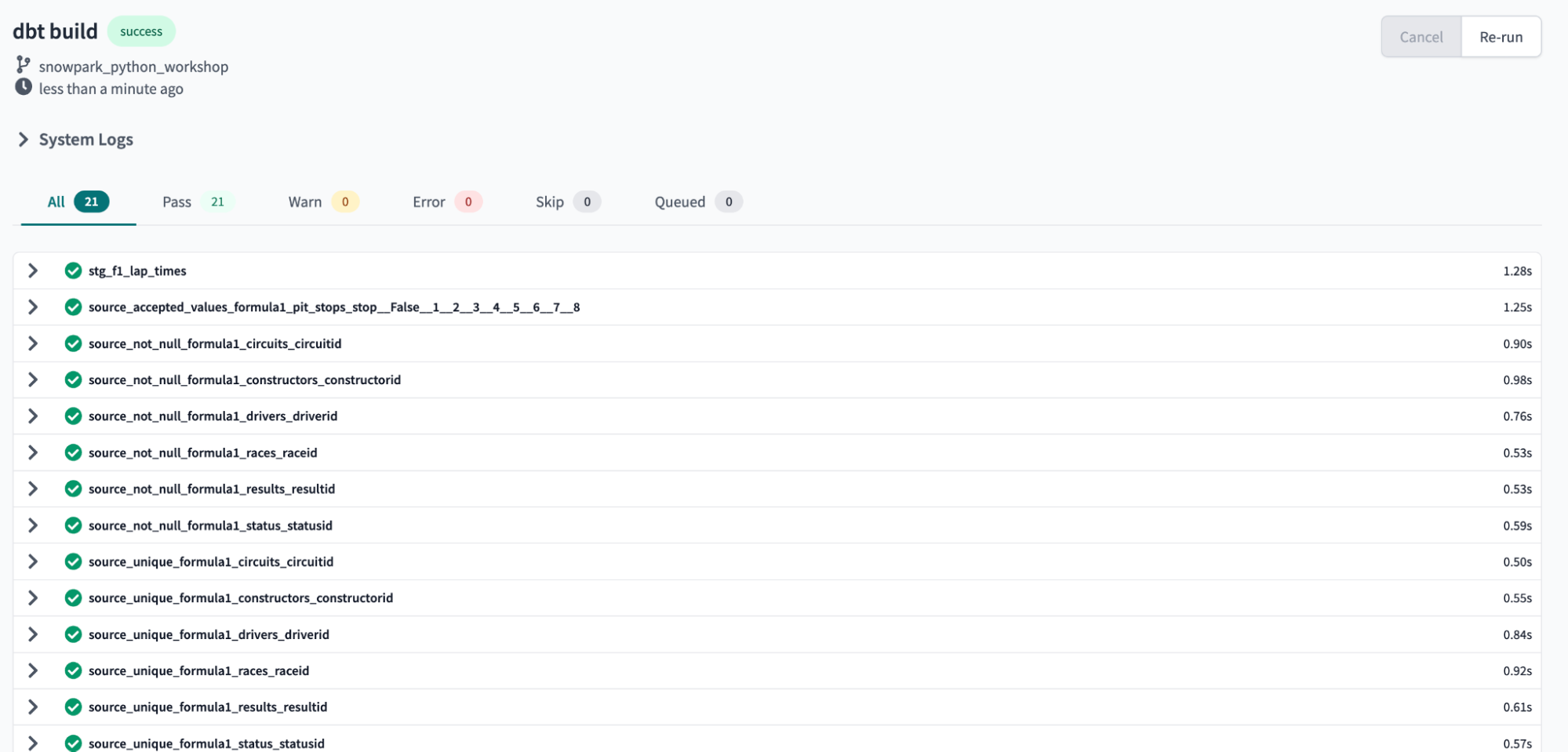

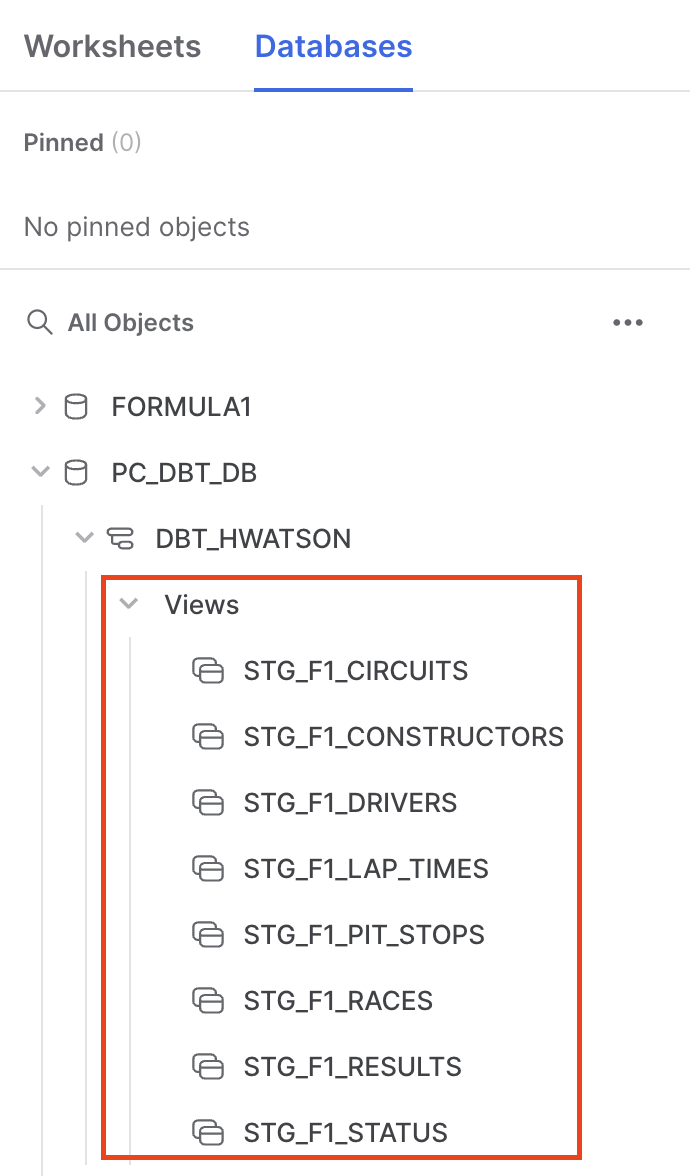

Теперь, когда модели подготовки созданы и сохранены, пришло время создать модели в нашей схеме разработки в Snowflake. Для этого мы введем в командной строке

dbt build, чтобы запустить все модели в нашем проекте, включая 8 новых моделей подготовки и существующие модели примеров.Ваше выполнение должно завершиться успешно, и вы должны увидеть зеленые галочки рядом со всеми вашими моделями в результатах выполнения. Мы построили наши 8 моделей подготовки как представления и запустили 13 тестов источников, которые мы настроили в файле

f1_sources.ymlс не таким уж большим количеством кода, довольно круто!Давайте быстро взглянем на Snowflake, обновим объекты базы данных, откроем нашу схему разработки и подтвердим, что новые модели там. Если вы можете их увидеть, значит, все в порядке!

Прежде чем перейти к следующему разделу, обязательно зафиксируйте ваши новые модели в вашей ветке Git. Нажмите Commit and push и дайте вашему коммиту сообщение, например, profile, sources, and staging setup, прежде чем продолжить.

Преобразование SQL

Теперь, когда у нас есть все наши источники и модели подготовки, пришло время перейти к тому, где dbt сияет — преобразование!

Нам нужно:

- Создать некоторые промежуточные таблицы для объединения таблиц, которые не являются иерархическими

- Создать основные таблицы для загрузки в инструменты бизнес-аналитики (BI)

- Ответить на два вопроса о:

- самых быстрых пит-стопах

- тенденциях времени круга в данных Формулы 1, создавая агрегированные модели с использованием Python!

Промежуточные модели

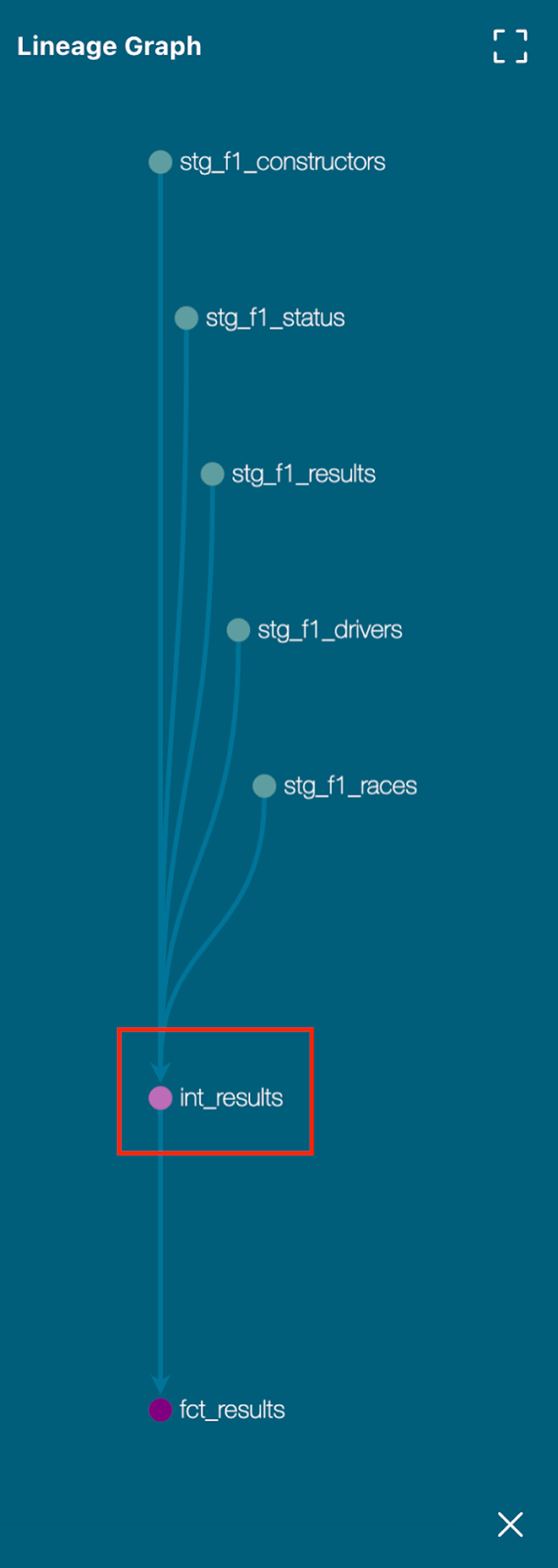

Нам нужно объединить множество справочных таблиц с нашей таблицей результатов, чтобы создать читаемую человеком таблицу данных. Что это значит? Например, мы не хотим иметь только числовой status_id в нашей таблице, мы хотим иметь возможность прочитать в строке данных, что водитель не смог завершить гонку из-за отказа двигателя (status_id=5).

К настоящему моменту мы довольно хорошо умеем создавать новые файлы в правильных каталогах, поэтому не будем подробно останавливаться на этом. Все промежуточные модели должны быть созданы в пути models/intermediate.

-

Создайте новый файл с именем

int_lap_times_years.sql. В этой модели мы объединяем информацию о времени круга и гонках, чтобы мы могли смотреть на время круга за годы. В более ранние эпохи Формулы 1 время круга не записывалось (только окончательные результаты), поэтому мы отфильтровываем записи, где время круга равно null.with lap_times as (

select * from {{ ref('stg_f1_lap_times') }}

),

races as (

select * from {{ ref('stg_f1_races') }}

),

expanded_lap_times_by_year as (

select

lap_times.race_id,

driver_id,

race_year,

lap,

lap_time_milliseconds

from lap_times

left join races

on lap_times.race_id = races.race_id

where lap_time_milliseconds is not null

)

select * from expanded_lap_times_by_year -

Создайте файл с именем

in_pit_stops.sql. Пит-стопы имеют отношение многие-к-одному (M:1) с нашими гонками. Мы создаем функциюtotal_pit_stops_per_race, разделяя поrace_idиdriver_id, сохраняя при этом индивидуальные пит-стопы для скользящего среднего в нашем следующем разделе.with stg_f1__pit_stops as

(

select * from {{ ref('stg_f1_pit_stops') }}

),

pit_stops_per_race as (

select

race_id,

driver_id,

stop_number,

lap,

lap_time_formatted,

pit_stop_duration_seconds,

pit_stop_milliseconds,

max(stop_number) over (partition by race_id,driver_id) as total_pit_stops_per_race

from stg_f1__pit_stops

)

select * from pit_stops_per_race -

Создайте файл с именем

int_results.sql. Здесь мы используем 4 наших таблицы —races,drivers,constructorsиstatus— чтобы дать контекст нашей таблицеresults. Теперь мы можем рассчитать новую функциюdrivers_age_years, приведяdate_of_birthиrace_yearв одну таблицу. Мы также создаем столбец, чтобы указать, не завершил ли водитель гонку, на основе того, была ли ихpositionравна null, называемогоdnf_flag.with results as (

select * from {{ ref('stg_f1_results') }}

),

races as (

select * from {{ ref('stg_f1_races') }}

),

drivers as (

select * from {{ ref('stg_f1_drivers') }}

),

constructors as (

select * from {{ ref('stg_f1_constructors') }}

),

status as (

select * from {{ ref('stg_f1_status') }}

),

int_results as (

select

result_id,

results.race_id,

race_year,

race_round,

circuit_id,

circuit_name,

race_date,

race_time,

results.driver_id,

results.driver_number,

forename ||' '|| surname as driver,

cast(datediff('year', date_of_birth, race_date) as int) as drivers_age_years,

driver_nationality,

results.constructor_id,

constructor_name,

constructor_nationality,

grid,

position,

position_text,

position_order,

points,

laps,

results_time_formatted,

results_milliseconds,

fastest_lap,

results_rank,

fastest_lap_time_formatted,

fastest_lap_speed,

results.status_id,

status,

case when position is null then 1 else 0 end as dnf_flag

from results

left join races

on results.race_id=races.race_id

left join drivers

on results.driver_id = drivers.driver_id

left join constructors

on results.constructor_id = constructors.constructor_id

left join status

on results.status_id = status.status_id

)

select * from int_results -

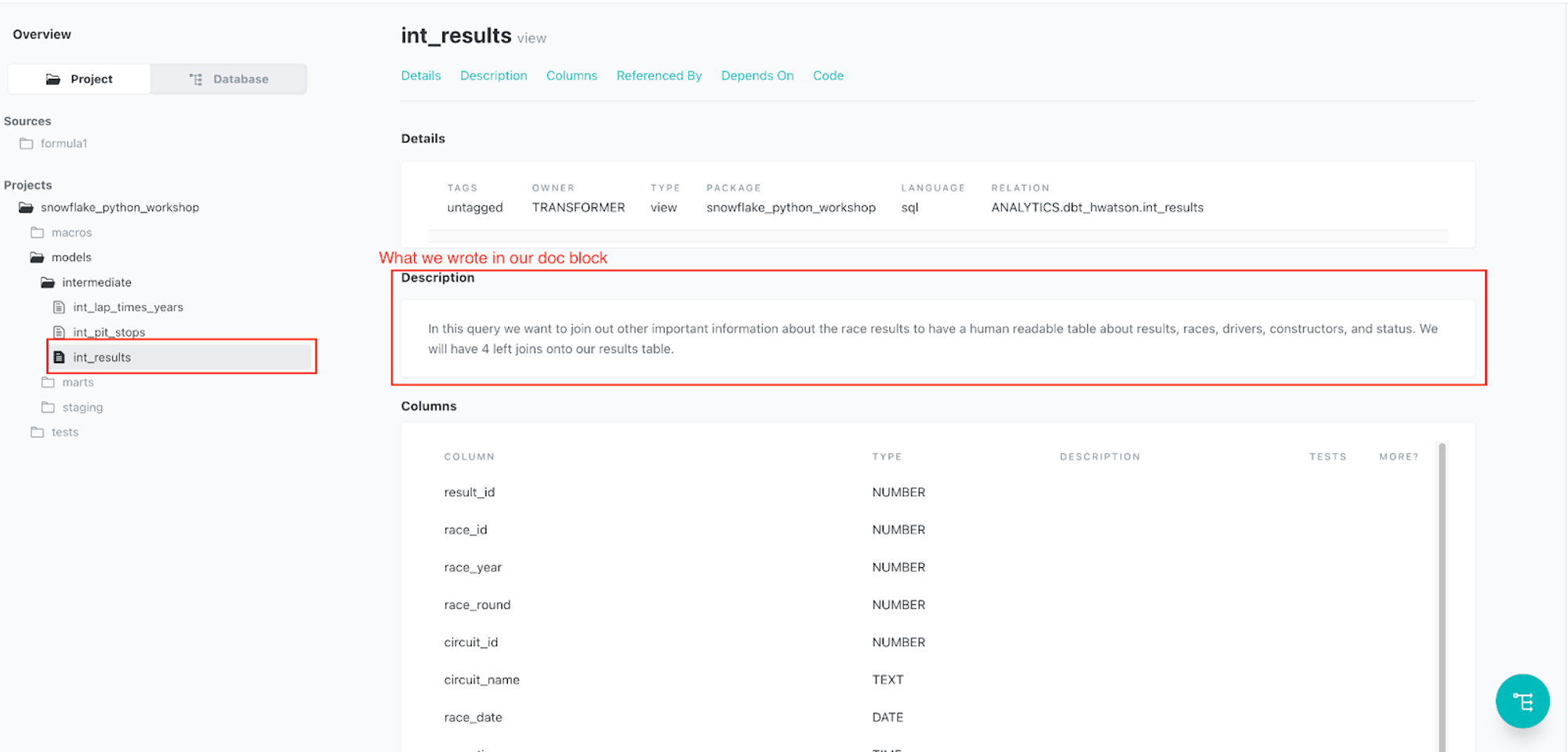

Создайте Markdown-файл

intermediate.md, который мы подробно разберём в разделах Test и Documentation руководства Leverage dbt to generate analytics and ML-ready pipelines with SQL and Python with Snowflake.# цель этого .md — позволить многострочные длинные объяснения для наших промежуточных преобразований

# ниже приведены описания

{% docs int_results %} В этом запросе мы хотим присоединить другую важную информацию о результатах гонок, чтобы иметь читаемую таблицу о результатах, гонках, водителях, конструкторах и статусе.

У нас будет 4 левых соединения с нашей таблицей результатов. {% enddocs %}

{% docs int_pit_stops %} В одной гонке много пит-стопов, то есть отношение M:1.

Мы хотим агрегировать это, чтобы мы могли правильно присоединить информацию о пит-стопах без создания фан-аута. {% enddocs %}

{% docs int_lap_times_years %} Время круга выполняется на круг. Нам нужно присоединить их к году гонки, чтобы понять тенденции времени круга за годы. {% enddocs %} -

Создайте YAML-файл

intermediate.yml, который мы подробно разберём в разделах Test и Document руководства Leverage dbt to generate analytics and ML-ready pipelines with SQL and Python with Snowflake.version: 2

models:

- name: int_results

description: '{{ doc("int_results") }}'

- name: int_pit_stops

description: '{{ doc("int_pit_stops") }}'

- name: int_lap_times_years

description: '{{ doc("int_lap_times_years") }}'Это завершает промежуточные модели, которые нам нужно создать для наших основных моделей!

Основные модели

-

Создайте файл

fct_results.sql. Это то, что я люблю называть "мега таблицей" — действительно большая денормализованная таблица со всем нашим контекстом, добавленным на уровне строк для читаемости человеком. Важно, что у нас есть таблицаcircuits, которая связана через таблицуraces. Когда мы присоединилиracesкresultsвint_results.sql, мы позволили нашим таблицам установить связь отcircuitsкresultsвfct_results.sql. Мы берем информацию о пит-стопах только на уровне результатов, чтобы наше соединение не вызвало фан-аута.with int_results as (

select * from {{ ref('int_results') }}

),

int_pit_stops as (

select

race_id,

driver_id,

max(total_pit_stops_per_race) as total_pit_stops_per_race

from {{ ref('int_pit_stops') }}

group by 1,2

),

circuits as (

select * from {{ ref('stg_f1_circuits') }}

),

base_results as (

select

result_id,

int_results.race_id,

race_year,

race_round,

int_results.circuit_id,

int_results.circuit_name,

circuit_ref,

location,

country,

latitude,

longitude,

altitude,

total_pit_stops_per_race,

race_date,

race_time,

int_results.driver_id,

driver,

driver_number,

drivers_age_years,

driver_nationality,

constructor_id,

constructor_name,

constructor_nationality,

grid,

position,

position_text,

position_order,

points,

laps,

results_time_formatted,

results_milliseconds,

fastest_lap,

results_rank,

fastest_lap_time_formatted,

fastest_lap_speed,

status_id,

status,

dnf_flag

from int_results

left join circuits

on int_results.circuit_id=circuits.circuit_id

left join int_pit_stops

on int_results.driver_id=int_pit_stops.driver_id and int_results.race_id=int_pit_stops.race_id

)

select * from base_results -

Создайте файл

pit_stops_joined.sql. Наши результаты и пит-стопы находятся на разных уровнях размерности (также называемых зернистостью). Проще говоря, у нас есть несколько пит-стопов на один результат. Поскольку мы заинтересованы в понимании информации на уровне пит-стопов с информацией о годе гонки и конструкторе, мы создадим новую таблицуpit_stops_joined.sql, где каждая строка будет на пит-стоп. Наша новая таблица подготавливает нашу агрегацию в Python.with base_results as (

select * from {{ ref('fct_results') }}

),

pit_stops as (

select * from {{ ref('int_pit_stops') }}

),

pit_stops_joined as (

select

base_results.race_id,

race_year,

base_results.driver_id,

constructor_id,

constructor_name,

stop_number,

lap,

lap_time_formatted,

pit_stop_duration_seconds,

pit_stop_milliseconds

from base_results

left join pit_stops

on base_results.race_id=pit_stops.race_id and base_results.driver_id=pit_stops.driver_id

)

select * from pit_stops_joined -

Введите в командной строке и выполните

dbt build, чтобы построить весь наш конвейер до этого момента. Не беспокойтесь о "перезаписи" ваших предыдущих моделей – рабочие процессы dbt разработаны так, чтобы быть идемпотентными, поэтому мы можем запускать их снова и ожидать тех же результатов. -

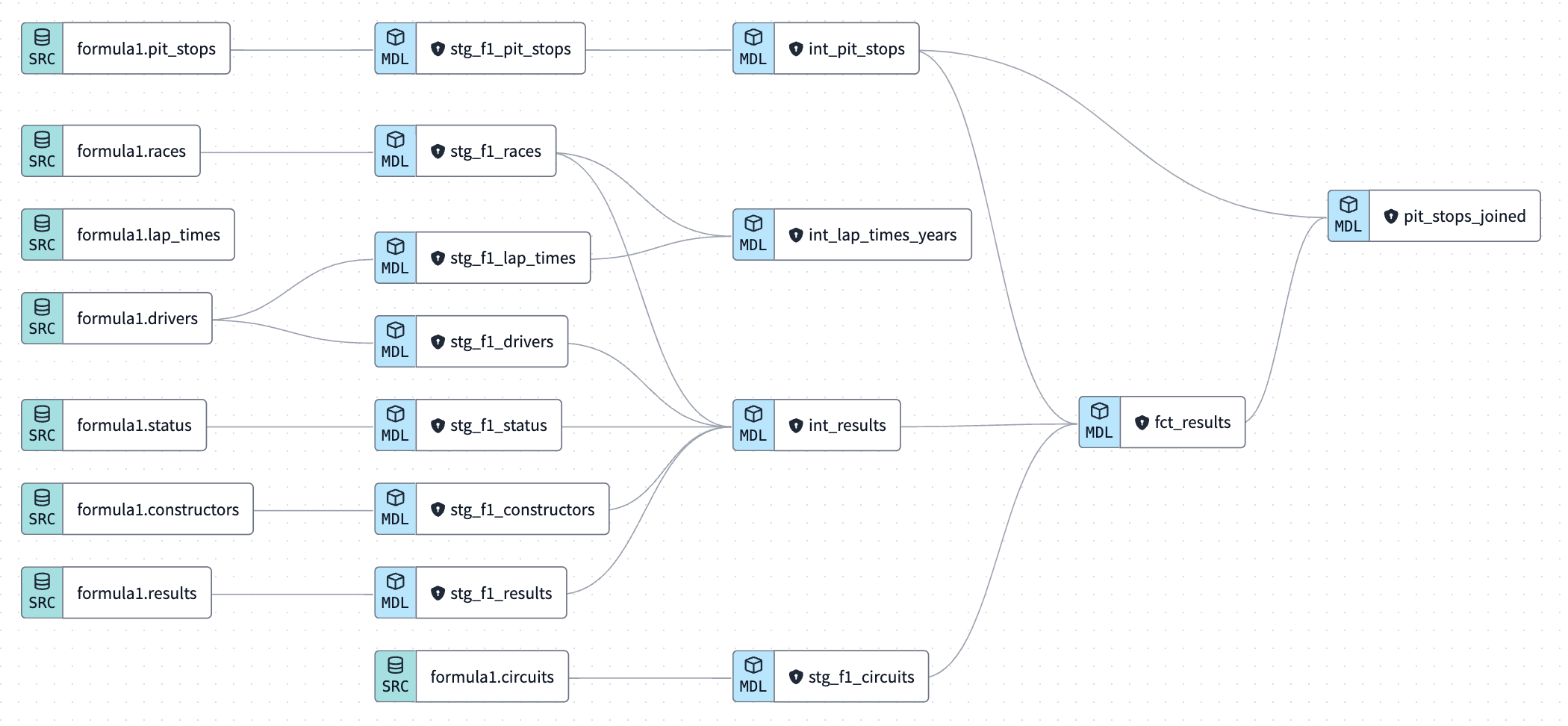

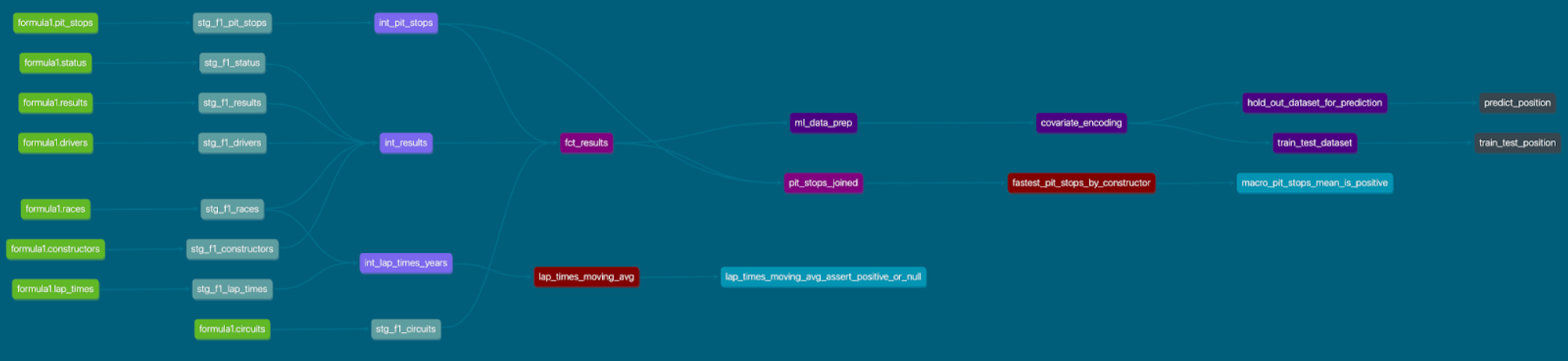

Давайте поговорим о нашей родословной до сих пор. Она выглядит хорошо 😎. Мы показали, как SQL можно использовать для изменения типа данных, имен столбцов и обработки иерархических соединений очень хорошо; все это время строя нашу автоматизированную родословную!

-

Время Commit and push наших изменений и дайте вашему коммиту сообщение, например,

intermediate and fact models, прежде чем продолжить.

Запуск моделей dbt Python

До сих пор SQL управлял проектом (автомобильная игра слов намерена) для очистки данных и иерархических соединений. Теперь пришло время Python взять на себя управление (автомобильная игра слов все еще намерена) на оставшуюся часть нашей лаборатории! Для получения дополнительной информации о запуске Python моделей на dbt ознакомьтесь с нашими документами. Чтобы узнать больше о том, как работает dbt python под капотом, ознакомьтесь с Snowpark for Python, который делает возможным запуск dbt Python моделей.

Существует довольно много различий между SQL и Python с точки зрения синтаксиса dbt и DDL, поэтому мы будем разбивать наш код и выполнение моделей дальше для наших python моделей.

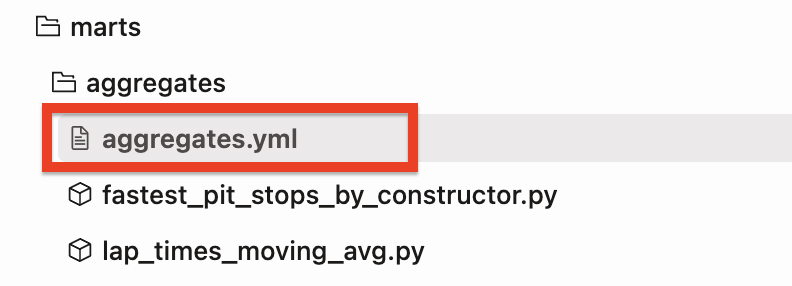

Анализ пит-стопов

Сначала мы хотим узнать: какой конструктор имел самые быстрые пит-стопы в 2021 году? (конструктор — это команда Формулы 1, которая строит или "конструирует" автомобиль).

-

Создайте новый файл с именем

fastest_pit_stops_by_constructor.pyв нашей папкеaggregates(это первый раз, когда мы используем расширение.py). -

Скопируйте следующий код в файл:

import numpy as np

import pandas as pd

def model(dbt, session):

# dbt configuration

dbt.config(packages=["pandas","numpy"])

# get upstream data

pit_stops_joined = dbt.ref("pit_stops_joined").to_pandas()

# provide year so we do not hardcode dates

year=2021

# describe the data

pit_stops_joined["PIT_STOP_SECONDS"] = pit_stops_joined["PIT_STOP_MILLISECONDS"]/1000

fastest_pit_stops = pit_stops_joined[(pit_stops_joined["RACE_YEAR"]==year)].groupby(by="CONSTRUCTOR_NAME")["PIT_STOP_SECONDS"].describe().sort_values(by='mean')

fastest_pit_stops.reset_index(inplace=True)

fastest_pit_stops.columns = fastest_pit_stops.columns.str.upper()

return fastest_pit_stops.round(2) -

Давайте разберем, что делает этот код шаг за шагом:

- Сначала мы импортируем библиотеки Python, которые мы используем. Библиотека — это повторно используемый фрагмент кода, написанный кем-то другим, который вы можете захотеть включить в свои программы/проекты. Мы используем

numpyиpandasв этой Python модели. Это похоже на пакет dbt, но наши библиотеки Python не сохраняются по всему проекту. - Определяем функцию с именем

modelс параметрамиdbtиsession. Параметрdbt— это класс, скомпилированный dbt, который позволяет вам запускать ваш Python код в контексте вашего проекта dbt и DAG. Параметрsession— это класс, представляющий соединение вашего Snowflake с бэкэндом Python. Функцияmodelдолжна возвращать один DataFrame. Вы можете видеть, что все преобразования данных происходят в теле функцииmodel, к которой привязано выражениеreturn. - Затем, в контексте нашей библиотеки моделей dbt, мы передаем конфигурацию, какие пакеты нам нужны, используя

dbt.config(packages=["pandas","numpy"]). - Используйте функцию

.ref(), чтобы получить фрейм данныхpit_stops_joined, который мы создали на предыдущем шаге, используя SQL. Мы приводим его к pandas dataframe (по умолчанию это Snowpark Dataframe). - Создайте переменную с именем

year, чтобы мы не передавали жестко закодированное значение. - Создайте новый столбец с именем

PIT_STOP_SECONDS, разделив значениеPIT_STOP_MILLISECONDSна 1000. - Создайте наш окончательный фрейм данных

fastest_pit_stops, который содержит записи, где год равен нашей переменной года (в данном случае 2021), затем сгруппируйте фрейм данных поCONSTRUCTOR_NAMEи используйте методыdescribe()иsort_values()в порядке убывания. Это сделает нашу первую строку в новом агрегированном фрейме данных командой с самыми быстрыми пит-стопами за весь год соревнований. - Наконец, он сбрасывает индекс фрейма данных

fastest_pit_stops. Методreset_index()позволяет сбросить индекс обратно к значениям по умолчанию 0, 1, 2 и т. д.; чтобы избежать этого, используйте параметр drop. Подумайте об этом как о сохранении ваших данных "плоскими и квадратными", а не "многоуровневыми". Если вы новичок в Python, сейчас может быть хорошее время узнать об индексах за 5 минут, так как это основа того, как Python извлекает, нарезает и обрабатывает данные. Аргументinplaceозначает, что мы перезаписываем существующий фрейм данных навсегда. Не бойтесь! Это то, что мы хотим сделать, чтобы избежать работы с многоиндексными фреймами данных! - Преобразуйте наши имена столбцов Python в верхний регистр, используя

.upper(), чтобы Snowflake их распознал. - Наконец, мы возвращаем наш фрейм данных с двумя десятичными знаками для всех столбцов, используя метод

round().

- Сначала мы импортируем библиотеки Python, которые мы используем. Библиотека — это повторно используемый фрагмент кода, написанный кем-то другим, который вы можете захотеть включить в свои программы/проекты. Мы используем

-

Если взглянуть на это немного шире, что мы делаем по-другому здесь в Python по сравнению с нашим типичным SQL кодом:

- Цепочка методов — это техника, при которой несколько методов вызываются на объекте в одном выражении, при этом каждый вызов метода изменяет результат предыдущего. Методы вызываются в цепочке, при этом вывод одного метода используется в качестве ввода для следующего. Эта техника используется для упрощения кода и повышения его читаемости за счет устранения необходимости в промежуточных переменных для хранения промежуточных результатов.

- Способ, которым вы видите цепочку методов в Python, — это синтаксис

.().(). Например,.describe().sort_values(by='mean'), где метод.describe()связан с.sort_values().

- Способ, которым вы видите цепочку методов в Python, — это синтаксис

- Метод

.describe()используется для генерации различных статистических данных о наборе данных. Он используется на pandas dataframe. Он дает быстрый и простой способ получить статистику вашего набора данных без написания нескольких строк кода. - Метод

.sort_values()используется для сортировки pandas dataframe или серии по одному или нескольким столбцам. Метод сортирует данные по указанным столбцам в порядке возрастания или убывания. Это эквивалентorder byв SQL.

Мы не будем так подробно разбирать наши последующие скрипты, но продолжим объяснять на высоком уровне, что делают новые библиотеки, функции и методы.

- Цепочка методов — это техника, при которой несколько методов вызываются на объекте в одном выражении, при этом каждый вызов метода изменяет результат предыдущего. Методы вызываются в цепочке, при этом вывод одного метода используется в качестве ввода для следующего. Эта техника используется для упрощения кода и повышения его читаемости за счет устранения необходимости в промежуточных переменных для хранения промежуточных результатов.

-

Постройте модель, используя интерфейс, который выполнит:

dbt run --select fastest_pit_stops_by_constructorв командной строке.

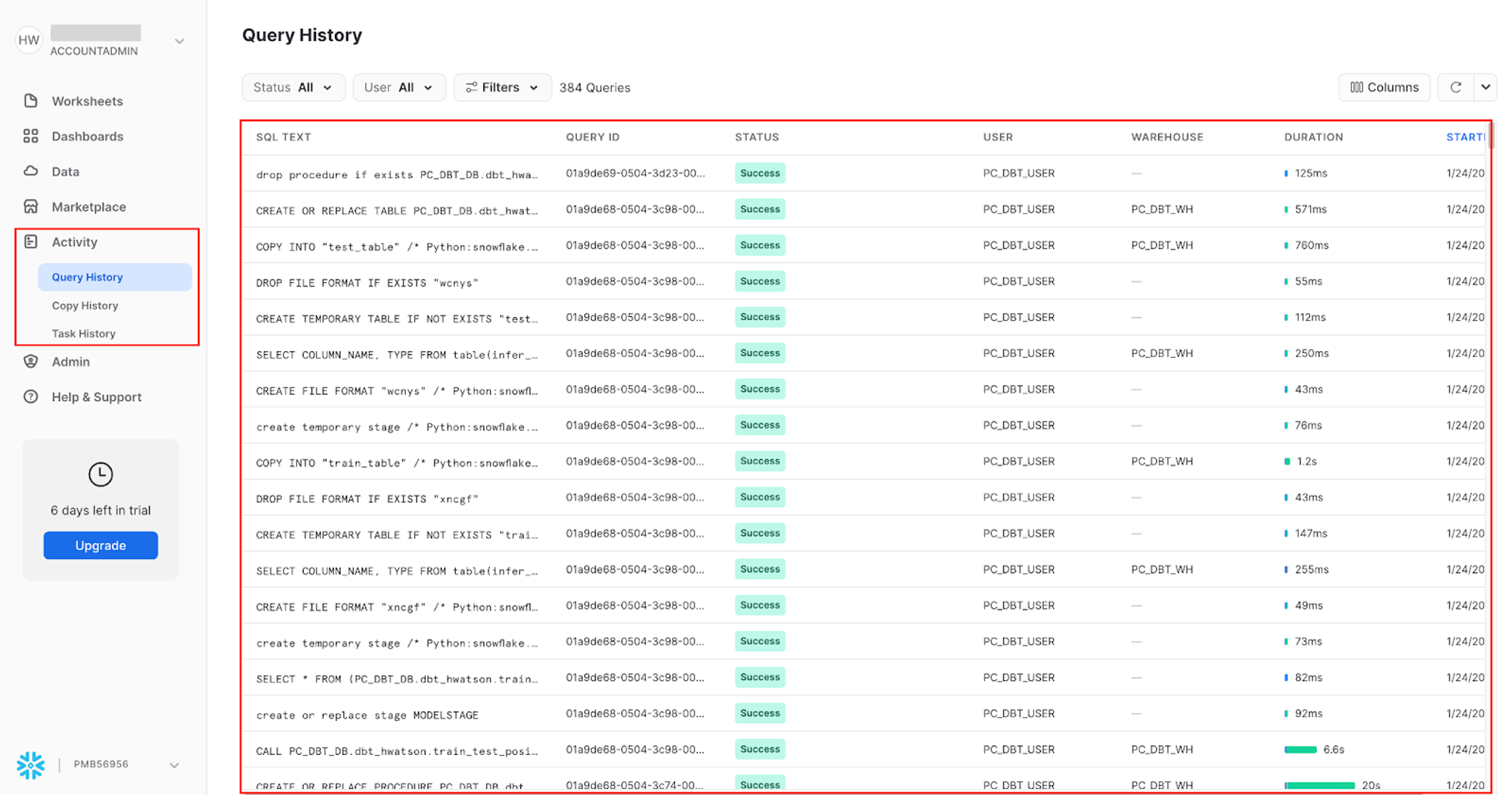

Давайте посмотрим на некоторые детали нашей первой Python модели, чтобы увидеть, что наша модель выполнила. Существует два основных различия, которые мы можем увидеть при запуске Python модели по сравнению с SQL моделью:

- Наша Python модель была выполнена как хранимая процедура. Snowflake нужно знать, что этот код предназначен для выполнения в среде выполнения Python, а не для интерпретации в среде выполнения SQL. Мы делаем это, создавая хранимую процедуру Python, вызываемую SQL командой.

- Библиотека

snowflake-snowpark-pythonбыла выбрана для выполнения нашего Python кода. Хотя это не было явно указано, это выбирается объектом класса dbt, потому что нам нужен наш пакет Snowpark для выполнения Python!

Python модели выполняются немного дольше, чем SQL модели, однако мы всегда можем ускорить это, используя Snowpark-оптимизированные склады, если захотим. Наши данные достаточно малы, поэтому мы не будем беспокоиться о создании отдельного склада для Python по сравнению с SQL файлами сегодня.

Мы можем видеть, что наша python модель выполняется как хранимая процедура в нашей личной схеме разработки

Мы можем видеть, что наша python модель выполняется как хранимая процедура в нашей личной схеме разработкиОстальная часть нашего Details вывода дает нам информацию о том, как dbt и Snowpark для Python работают вместе, чтобы определить объекты класса и применить определенный набор методов для выполнения наших моделей.

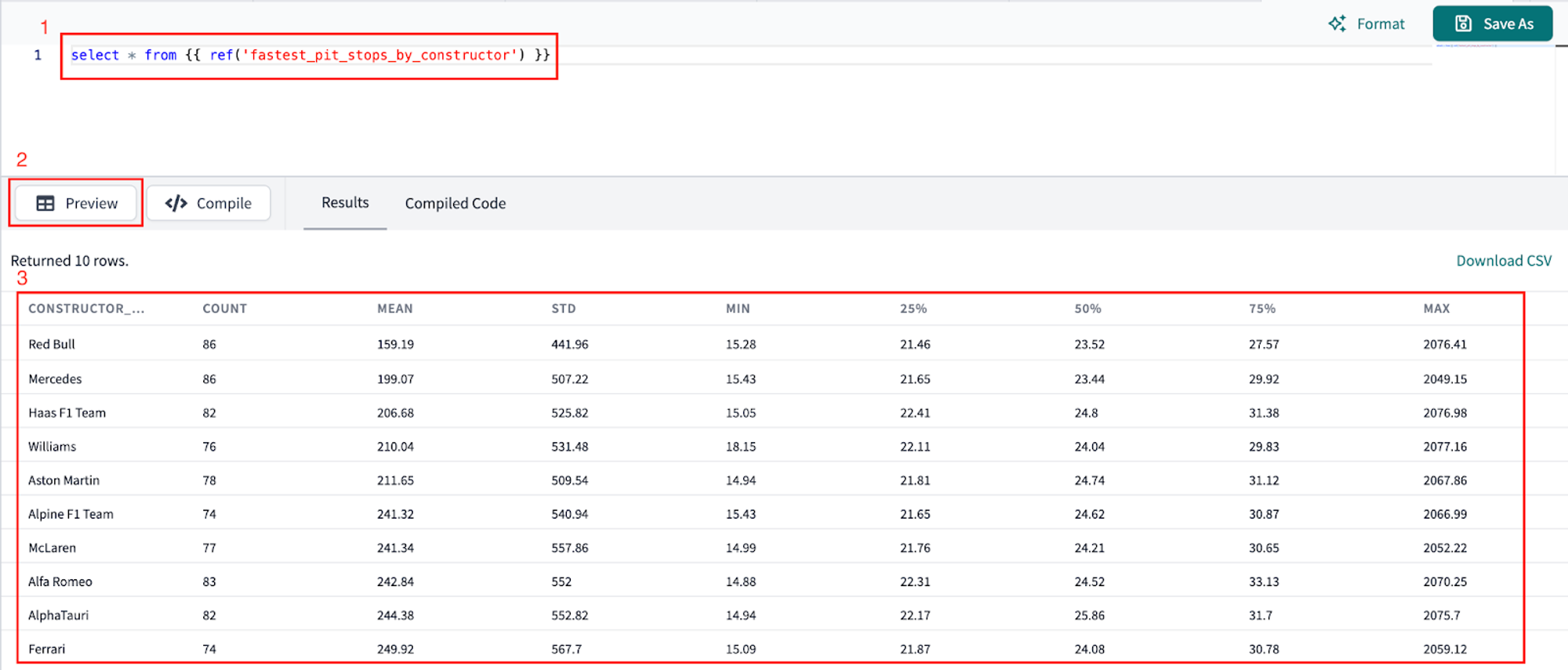

Итак, какой конструктор имел самые быстрые пит-стопы в 2021 году? Давайте посмотрим на наши данные, чтобы узнать!

-

Мы не можем предварительно просмотреть Python модели напрямую, поэтому давайте создадим новый файл, используя кнопку + или сочетание клавиш Control-n, чтобы создать новый черновик.

-

Сошлитесь на нашу Python модель:

select * from {{ ref('fastest_pit_stops_by_constructor') }}и предварительно просмотрите вывод:

Red Bull не только имел самые быстрые средние пит-стопы почти на 40 секунд, но и имел наименьшее стандартное отклонение, что означает, что они являются как самыми быстрыми, так и самыми последовательными командами в пит-стопах. Используя метод

.describe(), мы смогли избежать многословного SQL, требующего создания строки кода на столбец и повторного использования функцииPERCENTILE_COUNT().Теперь мы хотим найти среднее время круга и скользящее среднее за годы (в целом оно увеличивается или уменьшается)?

-

Создайте новый файл с именем

lap_times_moving_avg.pyв нашей папкеaggregates. -

Скопируйте следующий код в файл:

import pandas as pd

def model(dbt, session):

# dbt configuration

dbt.config(packages=["pandas"])

# get upstream data

lap_times = dbt.ref("int_lap_times_years").to_pandas()

# describe the data

lap_times["LAP_TIME_SECONDS"] = lap_times["LAP_TIME_MILLISECONDS"]/1000

lap_time_trends = lap_times.groupby(by="RACE_YEAR")["LAP_TIME_SECONDS"].mean().to_frame()

lap_time_trends.reset_index(inplace=True)

lap_time_trends["LAP_MOVING_AVG_5_YEARS"] = lap_time_trends["LAP_TIME_SECONDS"].rolling(5).mean()

lap_time_trends.columns = lap_time_trends.columns.str.upper()

return lap_time_trends.round(1) -

Разбирая наш код немного:

- Мы используем только библиотеку

pandasдля этой модели и приводим ее к pandas dataframe.to_pandas(). - Создайте новый столбец с именем

LAP_TIMES_SECONDS, разделив значениеLAP_TIME_MILLISECONDSна 1000. - Создайте окончательный фрейм данных. Получите время круга за год. Рассчитайте среднюю серию и преобразуйте в фрейм данных.

- Сбросьте индекс.

- Рассчитайте скользящее среднее за 5 лет.

- Округлите наши числовые столбцы до одного десятичного знака.

- Мы используем только библиотеку

-

Теперь запустите эту модель, используя интерфейс Run model или

dbt run --select lap_times_moving_avg

в командной строке.

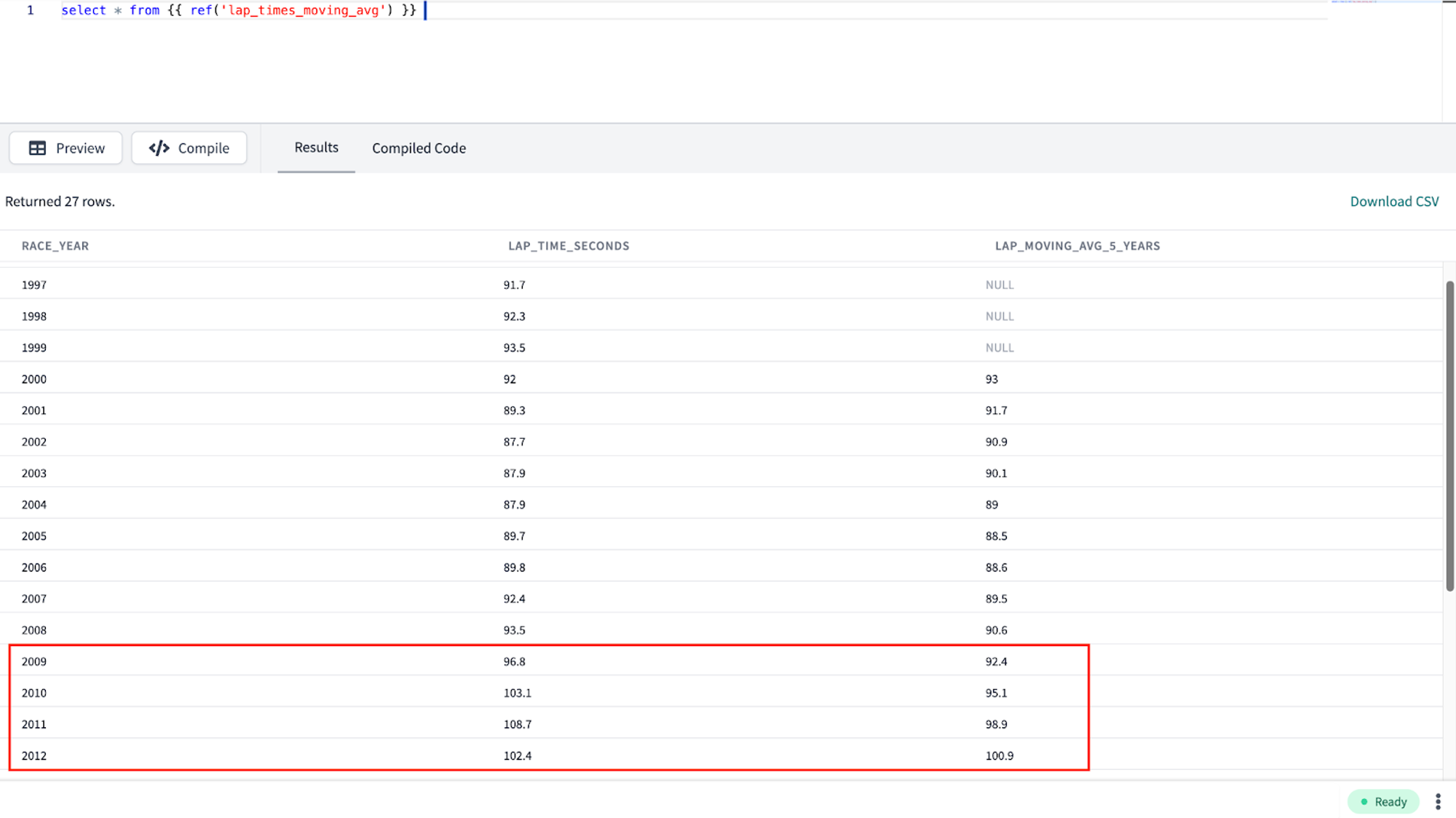

-

Еще раз предварительно просматривая вывод наших данных, используя те же шаги для нашей модели

fastest_pit_stops_by_constructor.Мы видим, что, похоже, время круга становится все быстрее со временем. Затем в 2010 году мы видим увеличение! Используя внешний контекст предметной области, мы знаем, что в 2010 и 2011 годах в Формуле 1 были введены значительные изменения правил, что привело к более медленному времени круга.

-

Сейчас хорошее время для контрольной точки и фиксации нашей работы в Git. Нажмите Commit and push и дайте вашему коммиту сообщение, например,

aggregate python models, прежде чем продолжить.

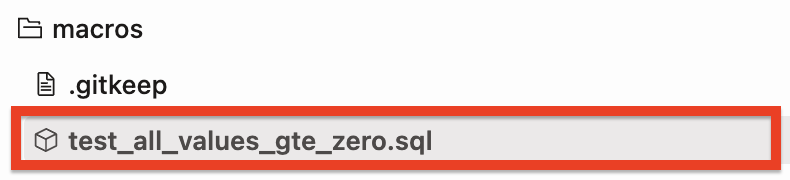

Модель dbt, функции .source(), .ref() и .config()

Давайте сделаем шаг назад перед началом машинного обучения, чтобы как пересмотреть, так и углубиться в методы, которые делают возможным запуск dbt python моделей. Если вы хотите узнать больше за пределами объяснений этой лаборатории, прочитайте документацию здесь.

-

Модель dbt (dbt, session). Для начала: каждая Python‑модель находится в отдельном файле

.pyв папкеmodels/. В этом файле определяется функция с именемmodel(), которая принимает два параметра:dbt— класс, скомпилированный dbt Core, уникальный для каждой модели. Он позволяет выполнять Python‑код в контексте вашего dbt‑проекта и DAG.session— класс, представляющий подключение вашей платформы данных к Python‑бэкенду.sessionнеобходим для чтения таблиц в виде DataFrame и записи DataFrame обратно в таблицы. В PySpark по соглашениюSparkSessionназываетсяsparkи доступна глобально. Для единообразия между платформами мы всегда передаём её в функцию модели как явный аргумент с именемsession.

-

Функция

model()должна возвращать один DataFrame. В Snowpark (Snowflake) это может быть Snowpark‑ или pandas‑DataFrame. -

Функции

.source()и.ref(). Python‑модели полностью участвуют в ориентированном ациклическом графе (DAG) преобразований dbt. Если вам нужно читать данные напрямую из сырой исходной таблицы, используйтеdbt.source(). Мы уже видели это в предыдущем разделе при использовании SQL с функциейsource. Эти функции выполняются одинаково, но имеют разный синтаксис. Используйте методdbt.ref()внутри Python‑модели, чтобы читать данные из других моделей (SQL или Python). Эти методы возвращают DataFrame, указывающие на вышестоящий источник, модель, seed или snapshot. -

.config(). Как и в SQL‑моделях, существует три способа конфигурации Python‑моделей:-

В отдельном файле

.ymlвнутри каталогаmodels/ -

В файле модели

.pyс использованием методаdbt.config() -

Вызов метода

dbt.config()задаёт конфигурации для вашей модели прямо в.py‑файле — аналогично макросу{{ config() }}в файлах моделей.sql:def model(dbt, session):

# установка конфигурации

dbt.config(materialized="table")

-

- Существует ограничение на то, насколько сложной может быть конфигурация при использовании метода `dbt.config()`. Он принимает только литеральные значения (строки, булевы значения и числовые типы). Передача другой функции или более сложной структуры данных невозможна. Причина в том, что dbt статически анализирует аргументы, переданные в `.config()`, во время парсинга модели, не выполняя ваш Python-код. Если вам нужно задать более сложную конфигурацию, мы рекомендуем определить её с помощью свойства `config` в YAML-файле свойств. Подробнее о конфигурациях можно узнать здесь.

Подготовка к машинному обучению: очистка, кодирование и разделение

Теперь, когда мы получили представления и бизнес-аналитику о Формуле 1 на описательном уровне, мы хотим расширить наши возможности в области прогнозирования. Мы собираемся рассмотреть сценарий, в котором мы цензурируем данные. Это означает, что мы будем притворяться, что обучаем модель, используя более ранние данные, и применяем ее к будущим данным. На практике это означает, что мы возьмем данные с 2010 по 2019 год для обучения нашей модели, а затем предскажем данные 2020 года.

В этом разделе мы будем готовить наши данные для прогнозирования итоговой позиции гонщика.

На высоком уровне мы будем:

- Создавать новые прогнозные признаки и фильтровать наш набор данных для активных гонщиков

- Кодировать наши данные (алгоритмы любят числа) и упрощать нашу целевую переменную, называемую

position - Разделять наш набор данных на обучение, тестирование и валидацию

Подготовка данных для ML

-

Чтобы наш проект был организован, нам нужно создать две новые подпапки в нашем каталоге

ml. В папкеmlсоздайте подпапкиprepиtrain_predict. -

Создайте новый файл в

ml/prep, назовите егоml_data_prep.py. Скопируйте следующий код в файл и сохраните.import pandas as pd

def model(dbt, session):

# конфигурация dbt

dbt.config(packages=["pandas"])

# получение данных из вышестоящей модели

fct_results = dbt.ref("fct_results").to_pandas()

# указание лет, чтобы не жестко кодировать даты в команде фильтрации

start_year=2010

end_year=2020

# описание данных за целое десятилетие

data = fct_results.loc[fct_results['RACE_YEAR'].between(start_year, end_year)]

# преобразование строки в целое число

data['POSITION'] = data['POSITION'].astype(float)

# мы не можем иметь null, если хотим использовать общее количество пит-стопов

data['TOTAL_PIT_STOPS_PER_RACE'] = data['TOTAL_PIT_STOPS_PER_RACE'].fillna(0)

# некоторые конструкторы изменили свое имя за годы, поэтому заменяем старые имена на текущие

mapping = {'Force India': 'Racing Point', 'Sauber': 'Alfa Romeo', 'Lotus F1': 'Renault', 'Toro Rosso': 'AlphaTauri'}

data['CONSTRUCTOR_NAME'].replace(mapping, inplace=True)

# создание метрик уверенности для гонщиков и конструкторов

dnf_by_driver = data.groupby('DRIVER').sum(numeric_only=True)['DNF_FLAG']

driver_race_entered = data.groupby('DRIVER').count()['DNF_FLAG']

driver_dnf_ratio = (dnf_by_driver/driver_race_entered)

driver_confidence = 1-driver_dnf_ratio

driver_confidence_dict = dict(zip(driver_confidence.index,driver_confidence))

dnf_by_constructor = data.groupby('CONSTRUCTOR_NAME').sum(numeric_only=True)['DNF_FLAG']

constructor_race_entered = data.groupby('CONSTRUCTOR_NAME').count()['DNF_FLAG']

constructor_dnf_ratio = (dnf_by_constructor/constructor_race_entered)

constructor_relaiblity = 1-constructor_dnf_ratio

constructor_relaiblity_dict = dict(zip(constructor_relaiblity.index,constructor_relaiblity))

data['DRIVER_CONFIDENCE'] = data['DRIVER'].apply(lambda x:driver_confidence_dict[x])

data['CONSTRUCTOR_RELAIBLITY'] = data['CONSTRUCTOR_NAME'].apply(lambda x:constructor_relaiblity_dict[x])

# удаление ушедших на пенсию гонщиков и конструкторов

active_constructors = ['Renault', 'Williams', 'McLaren', 'Ferrari', 'Mercedes',

'AlphaTauri', 'Racing Point', 'Alfa Romeo', 'Red Bull',

'Haas F1 Team']

active_drivers = ['Daniel Ricciardo', 'Kevin Magnussen', 'Carlos Sainz',

'Valtteri Bottas', 'Lance Stroll', 'George Russell',

'Lando Norris', 'Sebastian Vettel', 'Kimi Räikkönen',

'Charles Leclerc', 'Lewis Hamilton', 'Daniil Kvyat',

'Max Verstappen', 'Pierre Gasly', 'Alexander Albon',

'Sergio Pérez', 'Esteban Ocon', 'Antonio Giovinazzi',

'Romain Grosjean','Nicholas Latifi']

# создание флагов для активных гонщиков и конструкторов, чтобы мы могли фильтровать их в дальнейшем

data['ACTIVE_DRIVER'] = data['DRIVER'].apply(lambda x: int(x in active_drivers))

data['ACTIVE_CONSTRUCTOR'] = data['CONSTRUCTOR_NAME'].apply(lambda x: int(x in active_constructors))

return data -

Как обычно, давайте разберем, что мы делаем в этой Python модели:

- Сначала мы ссылаемся на нашу вышестоящую таблицу

fct_resultsи преобразуем ее в pandas dataframe. - Фильтруем по годам 2010-2020, так как нам нужно очистить все наши данные, которые мы используем для прогнозирования (как для обучения, так и для тестирования).

- Заполняем пустые данные для

total_pit_stopsи создаем сопоставление активных конструкторов и гонщиков, чтобы избежать ошибочных прогнозов.- ⚠️ Вы можете задаться вопросом, почему мы не сделали это в вышестоящей таблице

fct_results! Причина в том, что мы хотим, чтобы наша очистка для машинного обучения отражала 2020 год для наших прогнозов и давала нам актуальное название команды. Однако для целей бизнес-аналитики мы можем сохранить исторические данные на тот момент времени. Вместо того чтобы считать одну таблицу "единственным источником правды", мы создаем разные наборы данных для разных целей: один для исторических описаний и отчетности, а другой для актуальных прогнозов.

- ⚠️ Вы можете задаться вопросом, почему мы не сделали это в вышестоящей таблице

- Создаем новые признаки уверенности для гонщиков и конструкторов.

- Генерируем флаги для конструкторов и гонщиков, которые были активны в 2020 году.

- Сначала мы ссылаемся на нашу вышестоящую таблицу

-

Выполните следующее в командной строке:

dbt run --select ml_data_prep -

Есть еще аспекты, которые мы могли бы рассмотреть для этого проекта, такие как нормализация уверенности гонщика по количеству заездов. Включение этого помогло бы учесть историю гонщика и рассмотреть, является ли он новым или давно выступающим гонщиком. Мы собираемся пока оставить это простым, но это некоторые из способов, которыми мы можем расширить и улучшить наши проекты машинного обучения dbt. Разбирая нашу модель подготовки к машинному обучению:

- Лямбда-функции — Мы используем некоторые лямбда-функции для преобразования наших данных без необходимости создания полноценной функции с использованием нотации

def. Так что же такое лямбда-функции?- В Python лямбда-функция это небольшая, анонимная функция, определяемая с помощью ключевого слова "lambda". Лямбда-функции используются для выполнения быстрой операции, такой как математическое вычисление или преобразование списка элементов. Они часто используются в сочетании с функциями высшего порядка, такими как

apply,map,filterиreduce.

- В Python лямбда-функция это небольшая, анонимная функция, определяемая с помощью ключевого слова "lambda". Лямбда-функции используются для выполнения быстрой операции, такой как математическое вычисление или преобразование списка элементов. Они часто используются в сочетании с функциями высшего порядка, такими как

- Метод

.apply()— Мы использовали.apply(), чтобы передать наши функции в наши лямбда-выражения к столбцам и выполнить это несколько раз в нашем коде. Давайте объясним apply немного подробнее:- Функция

.apply()в библиотеке pandas используется для применения функции к указанной оси DataFrame или Series. В нашем случае функция, которую мы использовали, была нашей лямбда-функцией! - Функция

.apply()принимает два аргумента: первый это функция, которую нужно применить, и второй это ось, вдоль которой функция должна быть применена. Ось может быть указана как 0 для строк или 1 для столбцов. Мы используем значение по умолчанию 0, поэтому не пишем его явно в коде. Это означает, что функция будет применена к каждой строке DataFrame или Series.

- Функция

- Лямбда-функции — Мы используем некоторые лямбда-функции для преобразования наших данных без необходимости создания полноценной функции с использованием нотации

-

Давайте посмотрим на предварительный просмотр нашего очищенного dataframe после запуска нашей модели

ml_data_prep:

Кодирование ковариат

В следующей части мы будем выполнять кодирование ковариат. Разбирая это выражение, ковариата это переменная, которая имеет отношение к результату исследования или эксперимента, а кодирование относится к процессу преобразования данных (таких как текст или категориальные переменные) в числовой формат, который может быть использован в качестве входных данных для модели. Это необходимо, потому что большинство алгоритмов машинного обучения могут работать только с числовыми данными. Алгоритмы не говорят на языках, не видят изображения и т.д., поэтому мы кодируем наши данные в числа, чтобы алгоритмы могли выполнять задачи, используя вычисления, которые они иначе не могли бы.

🧠 Мы будем думать об этом как: "алгоритмы любят числа".

-

Создайте новый файл в

ml/prep, назовите егоcovariate_encoding, скопируйте код ниже и сохраните.import pandas as pd

import numpy as np

from sklearn.preprocessing import StandardScaler,LabelEncoder,OneHotEncoder

from sklearn.linear_model import LogisticRegression

def model(dbt, session):

# конфигурация dbt

dbt.config(packages=["pandas","numpy","scikit-learn"])

# получение данных из вышестоящей модели

data = dbt.ref("ml_data_prep").to_pandas()

# перечисление ковариат, которые мы хотим использовать в дополнение к целевой переменной, которую мы моделируем - position

covariates = data[['RACE_YEAR','CIRCUIT_NAME','GRID','CONSTRUCTOR_NAME','DRIVER','DRIVERS_AGE_YEARS','DRIVER_CONFIDENCE','CONSTRUCTOR_RELAIBLITY','TOTAL_PIT_STOPS_PER_RACE','ACTIVE_DRIVER','ACTIVE_CONSTRUCTOR', 'POSITION']]

# фильтрация ковариат по активным гонщикам и конструкторам

# используем fil_cov как сокращение для "filtered_covariates"

fil_cov = covariates[(covariates['ACTIVE_DRIVER']==1)&(covariates['ACTIVE_CONSTRUCTOR']==1)]

# Кодирование категориальных переменных с использованием LabelEncoder

# TODO: мы обновим это до ohe в будущем для неординальных переменных!

le = LabelEncoder()

fil_cov['CIRCUIT_NAME'] = le.fit_transform(fil_cov['CIRCUIT_NAME'])

fil_cov['CONSTRUCTOR_NAME'] = le.fit_transform(fil_cov['CONSTRUCTOR_NAME'])

fil_cov['DRIVER'] = le.fit_transform(fil_cov['DRIVER'])

fil_cov['TOTAL_PIT_STOPS_PER_RACE'] = le.fit_transform(fil_cov['TOTAL_PIT_STOPS_PER_RACE'])

# Упрощение целевой переменной "position" для представления 3 значимых категорий в Формуле 1

# 1. Позиция на подиуме 2. Очки для команды 3. Ничего - ни подиума, ни очков!

def position_index(x):

if x<4:

return 1

if x>10:

return 3

else :

return 2

# мы удаляем столбцы, по которым фильтровали, в дополнение к нашей обучающей переменной

encoded_data = fil_cov.drop(['ACTIVE_DRIVER','ACTIVE_CONSTRUCTOR'],axis=1))

encoded_data['POSITION_LABEL']= encoded_data['POSITION'].apply(lambda x: position_index(x))

encoded_data_grouped_target = encoded_data.drop(['POSITION'],axis=1))

return encoded_data_grouped_target -

Выполните следующее в командной строке:

dbt run --select covariate_encoding -

В этом коде мы используем множество функций из библиотек! Это действительно круто, потому что мы можем использовать код, разработанный другими людьми, и включать его в наш проект просто с помощью функции

import. Scikit-learn, сокращенно "sklearn", это чрезвычайно популярная библиотека для науки о данных. Sklearn содержит широкий спектр методов машинного обучения, включая алгоритмы обучения с учителем и без учителя, масштабирование признаков и импутацию, а также инструменты для оценки и выбора моделей. Мы будем использовать Sklearn как для подготовки наших ковариат, так и для создания моделей (наш следующий раздел). -

Наш набор данных довольно мал, поэтому мы можем использовать pandas и

sklearn. Если у вас есть более крупные данные для вашего собственного проекта, рассмотритеdaskилиcategory_encoders. -

Разбирая это немного подробнее:

- Мы выбираем подмножество переменных, которые будут использоваться в качестве предикторов для позиции гонщика.

- Фильтруем набор данных, чтобы включить только строки, используя флаги активных гонщиков и конструкторов, которые мы создали на предыдущем шаге.

- Следующий шаг - использование

LabelEncoderиз scikit-learn для преобразования категориальных переменныхCIRCUIT_NAME,CONSTRUCTOR_NAME,DRIVERиTOTAL_PIT_STOPS_PER_RACEв числовые значения. - Создаем новую переменную под названием

POSITION_LABEL, которая является производной от нашей переменной position.- 💭 Почему мы изменяем нашу переменную position? В Формуле 1 всего 20 позиций, и мы группируем их вместе, чтобы упростить классификацию и улучшить производительность. Мы также хотим показать, что вы можете создать новую функцию в вашей dbt модели!

- Наша новая переменная

position_labelимеет значение:- В Формуле 1, если вы находитесь:

- В топ-3, вы получаете позицию на "подиуме"

- В топ-10, вы получаете очки, которые добавляются к вашему общему сезону

- Ниже топ-10, вы не получаете очков!

- В Формуле 1, если вы находитесь:

- Мы сопоставляем нашу исходную переменную position с

position_labelс соответствующими местами выше на 1, 2 и 3 соответственно.

- Удаляем флаги активных гонщиков и конструкторов, так как они были критериями фильтрации, и дополнительно удаляем нашу исходную переменную position.

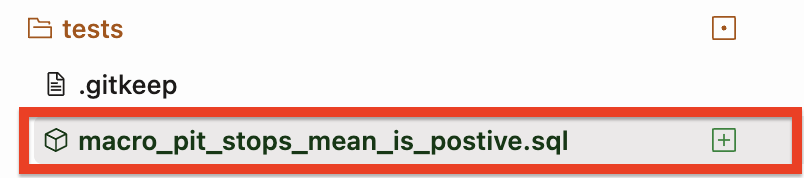

Разделение на обучающие и тестовые наборы данных

Теперь, когда мы очистили и закодировали наши данные, мы собираемся дополнительно разделить их по времени. На этом этапе мы создадим dataframes для использования в обучении и прогнозировании. Мы создадим два dataframes: 1) используя данные с 2010 по 2019 год для обучения, и 2) данные 2020 года для новых прогнозных выводов. Мы создадим переменные под названием start_year и end_year, чтобы мы не фильтровали по жестко заданным значениям (и могли бы легче их заменить в будущем, если захотим переобучить нашу модель на других временных рамках).

-

Создайте файл под названием

train_test_dataset.py, скопируйте и сохраните следующий код:import pandas as pd

def model(dbt, session):

# конфигурация dbt

dbt.config(packages=["pandas"], tags="train")

# получение данных из вышестоящей модели

encoding = dbt.ref("covariate_encoding").to_pandas()

# указание лет, чтобы не жестко кодировать даты в команде фильтрации

start_year=2010

end_year=2019

# описание данных за целое десятилетие

train_test_dataset = encoding.loc[encoding['RACE_YEAR'].between(start_year, end_year)]

return train_test_dataset -

Создайте файл под названием

hold_out_dataset_for_prediction.py, скопируйте и сохраните следующий код ниже. Теперь у нас будет набор данных только за 2020 год, который мы будем держать как отложенный набор, который мы будем использовать аналогично случаю развертывания.import pandas as pd

def model(dbt, session):

# конфигурация dbt

dbt.config(packages=["pandas"], tags="predict")

# получение данных из вышестоящей модели

encoding = dbt.ref("covariate_encoding").to_pandas()

# переменная для года вместо жесткого кодирования

year=2020

# фильтрация данных на основе указанного года

hold_out_dataset = encoding.loc[encoding['RACE_YEAR'] == year]

return hold_out_dataset -

Выполните следующее в командной строке:

dbt run --select train_test_dataset hold_out_dataset_for_predictionЧтобы запустить наши модели временного разделения данных, мы можем использовать этот синтаксис в командной строке, чтобы запустить их обе сразу. Убедитесь, что вы используете пробел синтаксис между именами моделей, чтобы указать, что вы хотите запустить обе!

-

Закоммитьте и отправьте наши изменения, чтобы продолжать сохранять нашу работу по мере продвижения, используя

ml data prep and splitsперед тем, как двигаться дальше.

👏 Теперь, когда мы закончили нашу подготовку к машинному обучению, мы можем перейти к самой интересной части — обучению и прогнозированию!

Обучение модели для прогнозирования в машинном обучении

Мы готовы начать обучение модели для прогнозирования позиции гонщика. Сейчас хорошее время, чтобы сделать паузу и сказать, что обычно в проектах ML вы попробуете несколько алгоритмов во время разработки и используете метод оценки, такой как кросс-валидация, чтобы определить, какой алгоритм использовать. Вы определенно можете сделать это в вашем проекте dbt, но для содержания этой лаборатории мы решили использовать логистическую регрессию для прогнозирования позиции (мы на самом деле попробовали некоторые другие алгоритмы, используя кросс-валидацию за пределами этой лаборатории, такие как k-ближайшие соседи и классификатор опорных векторов, но они не показали себя так хорошо, как логистическая регрессия и дерево решений, которое переобучилось).

Есть 3 области, которые нужно разобрать, так как мы работаем на пересечении всех в одном файле модели:

- Машинное обучение

- Snowflake и Snowpark

- dbt Python модели

Если вы не видели такой код раньше или не использовали файлы joblib для сохранения моделей машинного обучения, мы рассмотрим их на высоком уровне, и вы можете изучить ссылки для более технического углубления по пути! Поскольку Snowflake и dbt абстрагировали множество деталей о сериализации и хранении нашего объекта модели для повторного вызова, мы не будем вдаваться в слишком много деталей здесь. Здесь происходит многое, так что берите это в своем темпе!

Обучение и сохранение модели машинного обучения

-

Организация проекта остается ключевой, поэтому давайте создадим новую подпапку под названием

train_predictв папкеml. -

Теперь создайте новый файл под названием

train_test_position.pyи скопируйте и сохраните следующий код:import snowflake.snowpark.functions as F

from sklearn.model_selection import train_test_split

import pandas as pd

from sklearn.metrics import confusion_matrix, balanced_accuracy_score

import io

from sklearn.linear_model import LogisticRegression

from joblib import dump, load

import joblib

import logging

import sys

from joblib import dump, load

logger = logging.getLogger("mylog")

def save_file(session, model, path, dest_filename):

input_stream = io.BytesIO()

joblib.dump(model, input_stream)

session._conn.upload_stream(input_stream, path, dest_filename)

return "успешно создан файл: " + path

def model(dbt, session):

dbt.config(

packages = ['numpy','scikit-learn','pandas','numpy','joblib','cachetools'],

materialized = "table",

tags = "train"

)

# Создание стейджа в Snowflake для сохранения нашего файла модели

session.sql('create or replace stage MODELSTAGE').collect()

#session._use_scoped_temp_objects = False

version = "1.0"

logger.info('Версия обучения модели: ' + version)

# чтение нашего обучающего и тестового набора данных из вышестоящей модели

test_train_df = dbt.ref("train_test_dataset")

# приведение snowpark df к pandas df

test_train_pd_df = test_train_df.to_pandas()

target_col = "POSITION_LABEL"

# разделение ковариатных предикторов, x, от нашей целевой колонки position_label, y.

split_X = test_train_pd_df.drop([target_col], axis=1)

split_y = test_train_pd_df[target_col]

# Разделение нашего обучающего и тестового набора данных на пропорции

X_train, X_test, y_train, y_test = train_test_split(split_X, split_y, train_size=0.7, random_state=42)

train = [X_train, y_train]

test = [X_test, y_test]

# теперь мы обучаем только одну модель для развертывания

# мы сосредоточены на рабочих процессах, а не на алгоритмах для этой лаборатории!

model = LogisticRegression()

# подгонка предварительной обработки и модели вместе

model.fit(X_train, y_train)

y_pred = model.predict_proba(X_test)[:,1]

predictions = [round(value) for value in y_pred]

balanced_accuracy = balanced_accuracy_score(y_test, predictions)

# Сохранение модели на стейдже

save_file(session, model, "@MODELSTAGE/driver_position_"+version, "driver_position_"+version+".joblib" )

logger.info('Артефакт модели:' + "@MODELSTAGE/driver_position_"+version+".joblib")

# Преобразование наших pandas обучающих и тестовых dataframes обратно в snowpark dataframes

snowpark_train_df = session.write_pandas(pd.concat(train, axis=1, join='inner'), "train_table", auto_create_table=True, create_temp_table=True)

snowpark_test_df = session.write_pandas(pd.concat(test, axis=1, join='inner'), "test_table", auto_create_table=True, create_temp_table=True)

# Объединение наших обучающих и тестовых данных вместе и добавление колонки, указывающей на строки обучения и тестирования

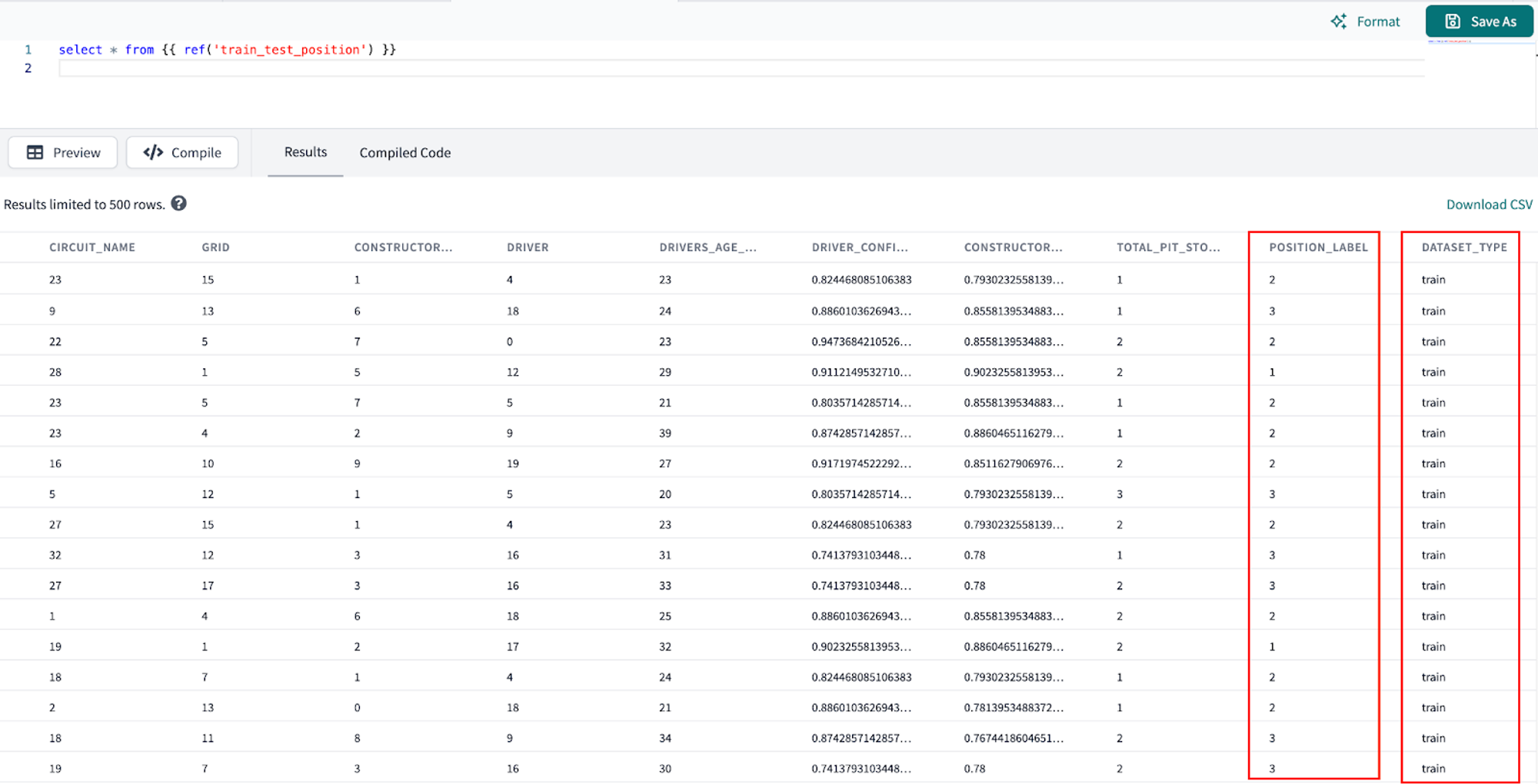

return snowpark_train_df.with_column("DATASET_TYPE", F.lit("train")).union(snowpark_test_df.with_column("DATASET_TYPE", F.lit("test"))) -

Выполните следующее в командной строке:

dbt run --select train_test_position -

Разбирая наш Python скрипт здесь:

- Мы импортируем некоторые полезные библиотеки.

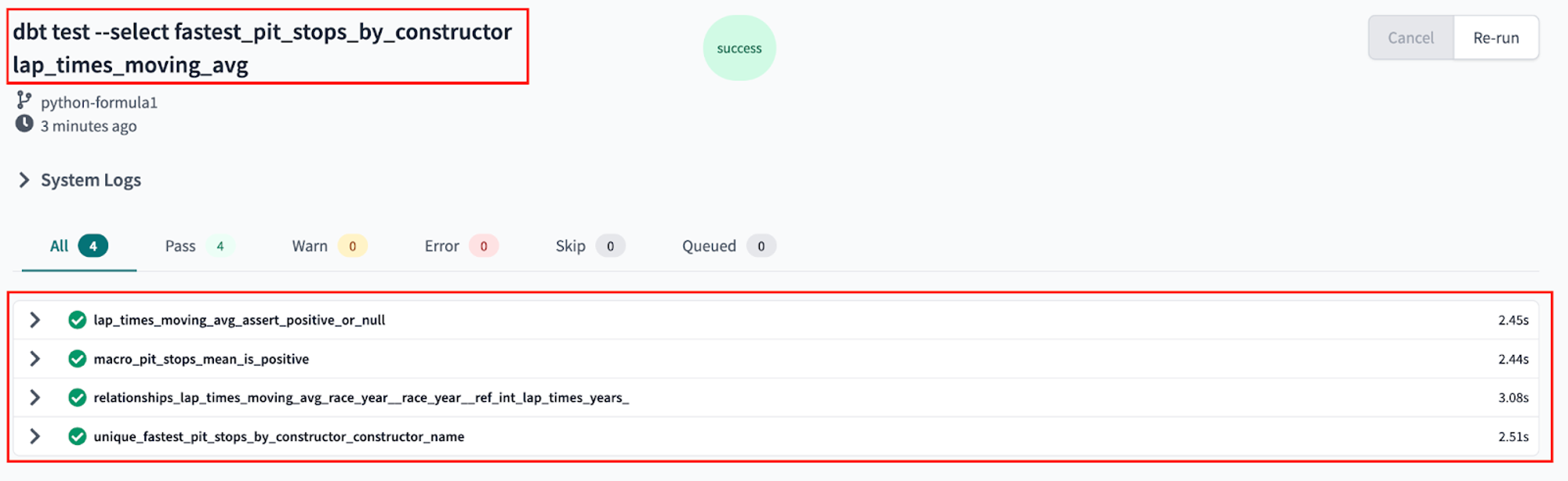

- Определяем функцию