Подключение Onehouse

dbt поддерживает подключение к Onehouse SQL с использованием Apache Spark Connector через метод Thrift.

примечание

Подключайтесь к Onehouse SQL Cluster с помощью адаптера dbt-spark.**

Требования

- Для dbt убедитесь, что ваш Onehouse SQL endpoint доступен через внешний DNS/IP, и выполнена настройка whitelisting IP-адресов dbt.

Что работает

- Все команды dbt, включая:

dbt clean,dbt compile,dbt debug,dbt seedиdbt run. - Материализации dbt:

tableиincremental - Типы таблиц Apache Hudi: Merge on Read (MoR) и Copy on Write (CoW). Для изменяемых (mutable) нагрузок рекомендуется использовать MoR.

Ограничения

- Представления (views) не поддерживаются

- Для

dbt seedсуществуют ограничения по количеству строк / записей. dbt seedподдерживает только таблицы Copy on Write.

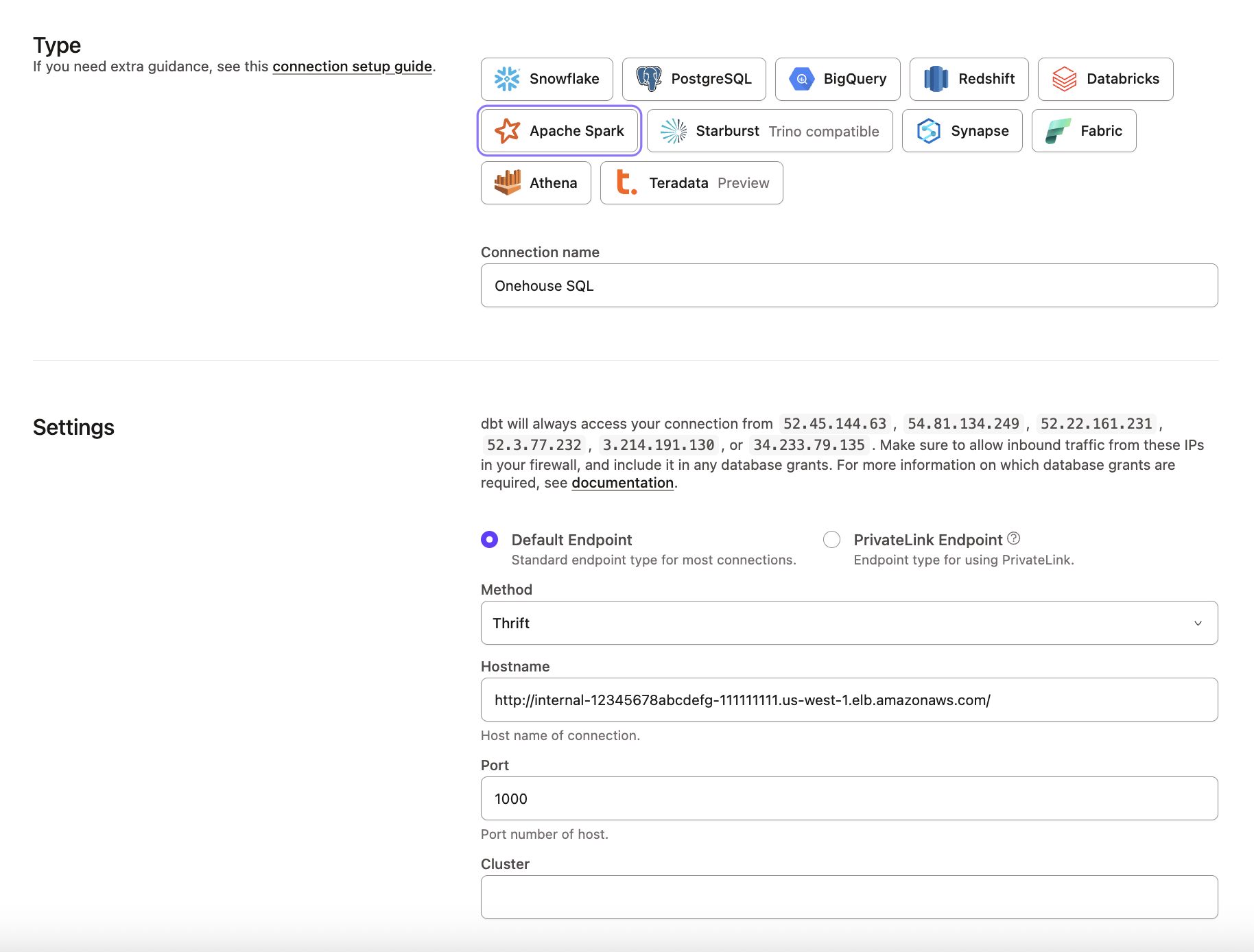

Подключение dbt

При создании подключения Apache Spark с использованием метода Thrift заполните следующие поля:

| Loading table... |

проект dbt

Мы рекомендуем задать конфигурации по умолчанию в dbt_project.yml, чтобы адаптер выполнялся с SQL, совместимым с Onehouse.

| Loading table... |

Шаблон dbt_project.yml

+materialized: table | incremental

+file_format: hudi

+location_root: <storage_uri>

+tblproperties:

hoodie.table.type: mor | cow

Пример dbt_project.yml при использовании jaffle shop:

models:

jaffle_shop:

+file_format: hudi

+location_root: s3://lakehouse/demolake/dbt_ecomm/

+tblproperties:

hoodie.table.type: mor

staging:

+materialized: incremental

marts:

+materialized: table

Нашли ошибку?

0